Интеллектуальный взрыв

Надеюсь, вы насладились временем, пока все было безобидно, потому что с этого момента вся эта история с ИИ начнет становиться ненормальной и пугающей. Я хочу напомнить, всё, что я буду говорить, по–прежнему имеет реальные научные подтверждения и является прогнозом на будущее, который составили самые высокоуважаемые мыслители и ученые современности. Просто держите это в уме, пока читаете. Во всяком случае, как я уже сказал выше, большинство вариантов развития событий, по которым мы доберемся до AGI, подразумевают процесс самосовершенствования ИИ. И как только появится AGI, даже системы, которые разрабатывались с помощью методов, не включавших в себя самопрограммирование, станут достаточно умными, чтобы начать самостоятельно вносить в свою архитектору изменения, если они этого захотят. И вот тут вся концепция начинает становиться еще интереснее. Давайте введем новое понятие: рекурсивное самосовершенствование. Работает оно следующим образом: Система ИИ в какой–то момент, скажем, на уровне тупого деревенщины, программируется на самосовершенствование. Как только это происходит и она становится умнее, достигая уровня Эйнштейна, она продолжает развиваться, но уже обладая интеллектом Эйнштейна, на что будет требоваться меньше времени. По мере того, как скачки в развитии будут увеличиваться, AGI достигнет уровня ASI — это и называется Интеллектуальным Взрывом и служит окончательным примером действия Закона ускоряющейся отдачи. Ведутся некоторые споры о том, как скоро ИИ достигнет общего уровня человеческого интеллекта. По опросам сотен ученых, это, вероятно, произойдет к 2040, что всего через 25 лет, и это не так уж и нескоро. Но может произойти и следующее: Слабому ИИ потребуется несколько десятилетий, чтобы стать AGI с низким уровнем интеллекта, но в конечном итоге это все равно произойдет. Компьютер будет способен понимать окружающий мир на уровне четырехлетнего ребенка, но уже через час он будет понимать сложнейшую теорию физики, которая объединяет теорию относительности с теорией квантовой механики, что не удавалось сделать ни одному человеку. Через еще полтора часа AGI достигает уровня ASI и будет превышать интеллект любого человека в 170000 раз или 270000, или какая разница вообще. Сверхинтеллект такой величины мы даже отдаленно понять не сможем. Все равно, что шмель попытается разобраться в Кейнсианской экономике. В нашем мире уровень IQ составляет в среднем 130 баллов для умного человека и 85 для глупого, мы даже не способны представить уровень IQ в 12952. Точно известно, что абсолютное доминирование людей на Земле предполагает четкое правило – с разумом приходит сила. Это означает, что ASI станет самым мощным созданием, когда–либо существовавшим на Земле, и это может произойти через несколько десятилетий. Если наши скудные мозги были способны придумать Wi–Fi, то чему–то, что в 100 или 1000 или 1000000000 раз умнее, чем мы, не составит труда контролировать расположение каждого отдельного атома во вселенной. Все, что мы привыкли воспринимать как некую магию, любая сила, считавшаяся нами чем–то божественным, станет для ASI простой, как выключение света. Создание технологии обратного старения человека, лечение болезней и голода, перепрограммирование погоды для защиты будущей жизни на Земле — все это станет возможным. Но также возможным будет и моментальное прекращение существования всех форм жизни на Земле. ASI станет всемогущий Богом на Земле, и самым важным вопросом для нас останется тогда этот:

Будет ли этот Бог добрым?

«Перед нами стоит чрезвычайно сложная задача. и неизвестно, сколько времени потребуется на ее решение, вполне возможно, от этого зависит судьба всего человечества» — Ник Бостром

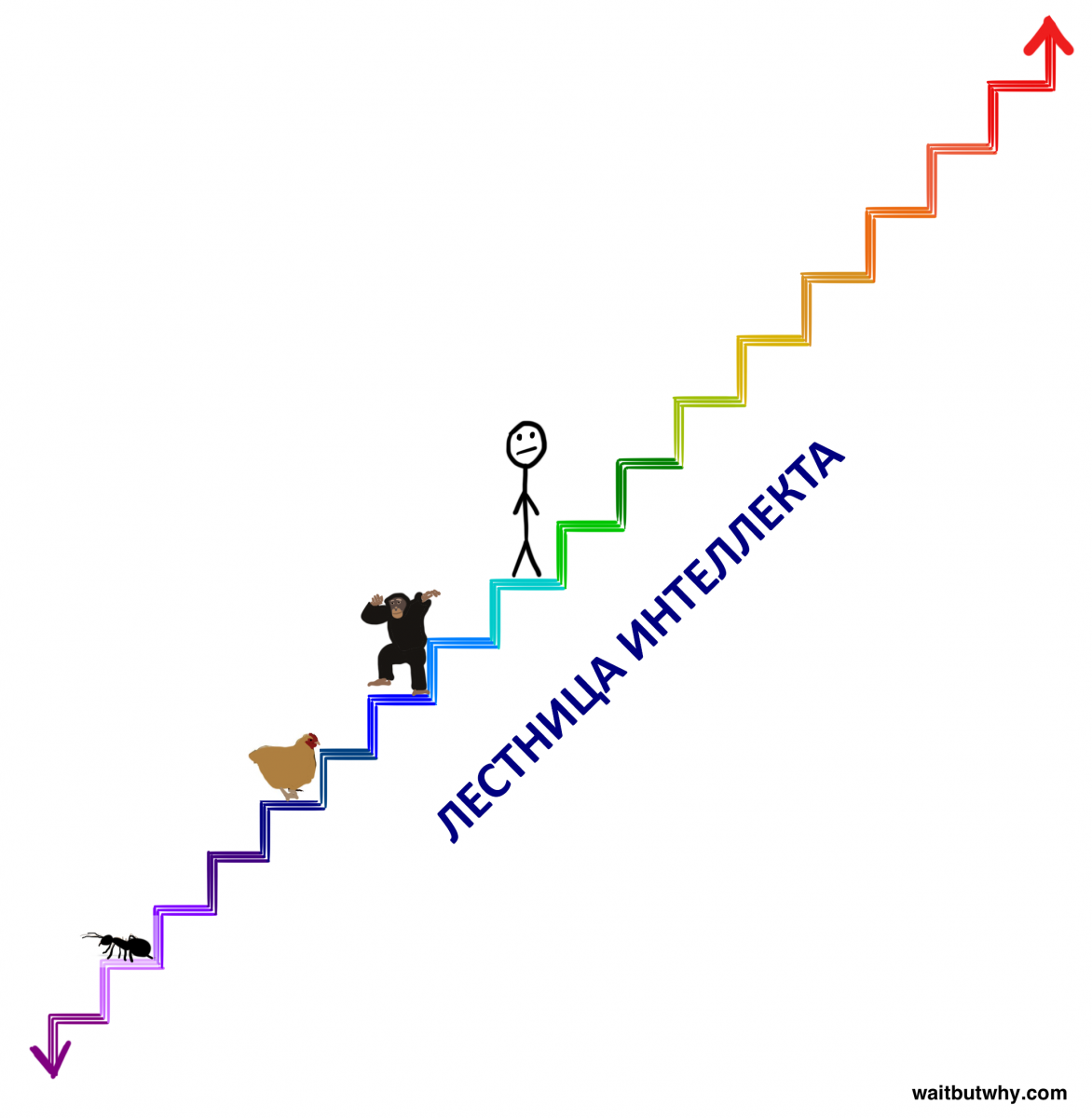

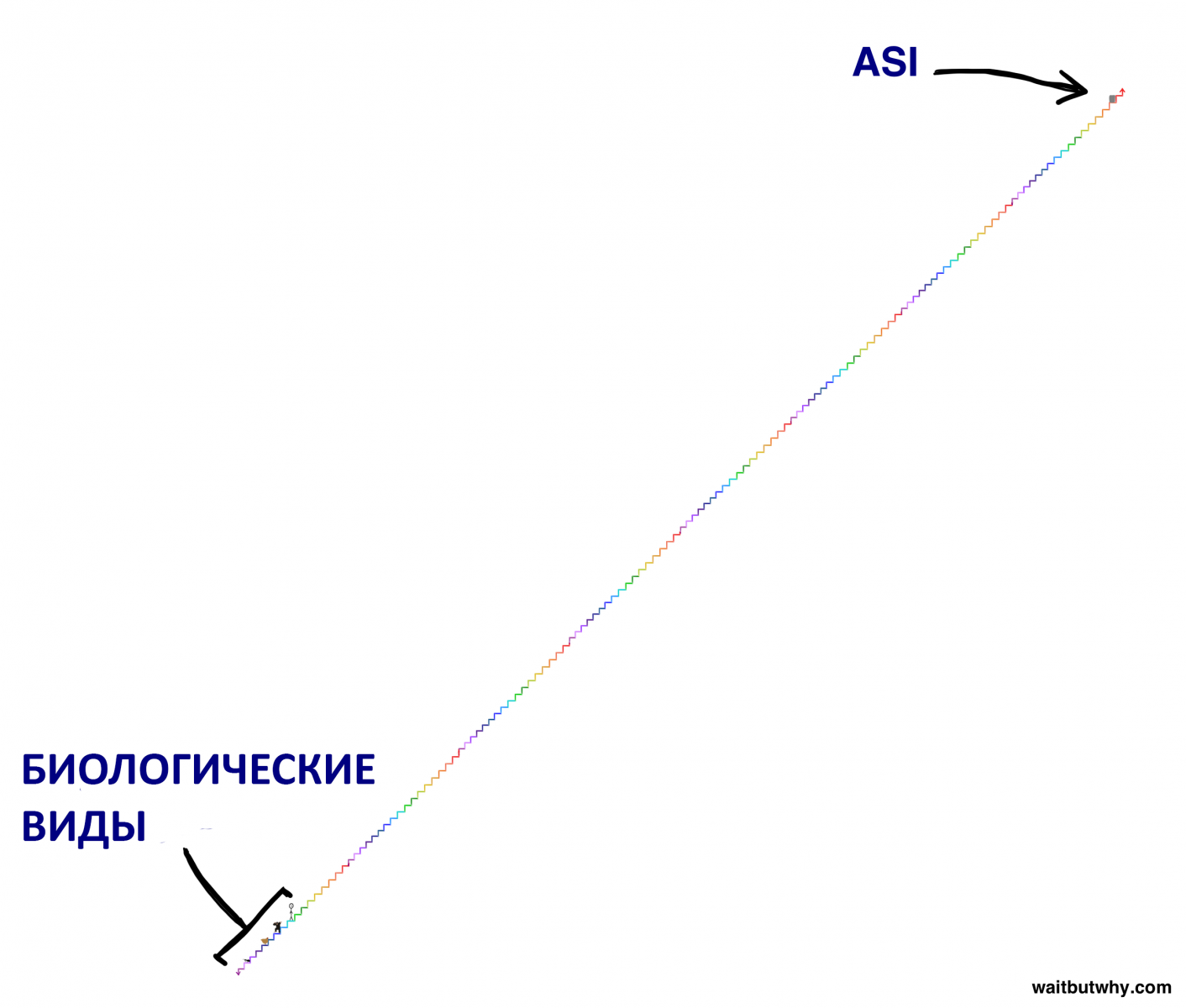

Теперь вы, уставившись в экраны мониторов, наверное, гадаете, какие чувства вам следует испытывать, пока вы пытаетесь переварить эту информацию. Тем временем, до того, как окунуться во все это с головой, давайте вспомним, что значит для машины обладание сверхинтеллектом. Существует ключевое различие между быстрым сверхинтеллектом и качественным сверхинтеллектом. Часто, когда мы пытаемся представить суперумный компьютер, мы первым делом думаем, что он так же умен, как и человек, только способен думать намного быстрее (вспомните х/ф «Она», скорость является основной чертой, отличающей супер ОС от человека), то есть, ему потребуется минут пять, чтобы решить задачу, на которую у человека уйдет лет десять. Звучит впечатляюще, и ASI действительно будет мыслить в разы быстрее любого человека, но настоящее отличие будет заключаться в качестве этого мышления, а не в его скорости, что принципиально все меняет. Разница в умственных способностях между человеком и шимпанзе заключается не в скорости мышления, а в том, что человеческий мозг содержит большее количество сложных когнитивных модулей, которые позволяют нам строить сложные лингвистические обозначения, долгосрочные планы или отвлеченные рассуждения, тогда как мозг шимпанзе на это просто не способен. Ускорение работы мозга шимпанзе в тысячу раз не принесет такого результата даже через десятилетие. Шимпанзе по–прежнему не будет способен собрать замысловатую модель, используя набор специальных инструментов, тогда как человек справится с этим за пару часов. Существует огромное количество когнитивных функций, которые никогда не станут доступны шимпанзе, вне зависимости от того, сколько времени у него уйдет на попытки. Проблема не в том, что шимпанзе не может делать то же, что под силу нам, а в том, что шимпанзе даже не способен понять, что такие возможности существуют. Шимпанзе может приблизительно понимать, что такое человек и что такое небоскреб, но он никогда не поймет, что люди построили небоскребы. Для шимпанзе все большое является частью природы и точка, сама возможность построить небоскреб лежит за гранью его понимания. Все это является результатом небольшого различия в качестве разума. В масштабе интеллектуального диапазона, о котором мы говорим сейчас, или даже такого диапазона между биологическими существами, разница между интеллектом шимпанзе и интеллектом человека ничтожно мала. Специально для вас я решил выстроить в ряд биологические существа по уровню их когнитивных возможностей, используя изображение лестницы (А — Расположение этих существ на лестнице не основано ни на каких научных данных и просто призвано донести общую суть, Б – я очень горжусь этими рисунками):

Теперь для того, чтобы понять, насколько важным будет появление сверхразумных компьютеров, представьте, что один из них находится на той темно–зеленой ступени, что на две выше, чем человек. И это будет всего лишь слегка сверхразумная машина, но разница в когнитивных способностях между ней и нами будет такой же, как и разница между человеком и шимпанзе. Как и шимпанзе, неспособный понять небоскребы, мы никогда не сможем понять что–то, что под силу компьютеру на темно–зеленой ступени, даже если бы он постарался нам это объяснить, не говоря уже о том, чтобы сделать это самим. И он всего только на две ступни выше нас. Машина на предпоследней ступени сверху будет для нас, как мы для муравьев, она может годами пытаться дать нам простейшее представление о том, что ей известно, и все будет без толку. Но сверхинтеллект, о котором мы говорим, сейчас расположен далеко за пределами этой лестницы. При интеллектуальном взрыве, чем умнее машина становится, тем быстрее она способна совершенствовать свой интеллект. Машине могут потребоваться годы, чтобы сделать шаг и стать на ступень выше шимпанзе, но потом, возможно, ей понадобится всего несколько часов, чтобы перепрыгнуть на темно–зеленую ступень, после чего дальнейшие скачки будут занимать считанные секунды. Поэтому важно понимать, что пройдет совсем немного времени от момента, когда мы услышим новости о создании первого компьютера, сравнимого по интеллекту с человеком, до момента, когда мы начнем сосуществовать на Земле с компьютерами, которые будут на миллионы ступеней выше нас.

Раз мы уже договорились, что нет смысла даже пытаться понять машину, которая на две ступени выше нас, давайте конкретно раз и навсегда договоримся, что нет ни малейшего шанса предугадать, что сделает с нами ASI и какими для нас окажутся последствия. Любой, кто попытается сделать вид, что может это предсказать, явно ничего не смыслит в сверхинтеллекте. Эволюция совершенствовала биологический мозг медленно и постепенно в течение сотен миллионов лет, и в этом плане создание человеком сверхинтеллекта будет большим плевком в сторону эволюции. Хотя, возможно, это и есть часть эволюции – может, она устроена таким образом, что человеческий разум развивается до тех пор, пока он не становится способен создать искусственный сверхразум, что служит неким детонатором. который вызовет взрыв, определяющий будущее для всех живых организмов:

По причинам, которые мы обсудим позже, большая часть научного сообщества считает, что вопрос не в том, наступим ли мы на эту мину, а когда. Такая информация немного сносит крышу.

И куда это нас приведет?

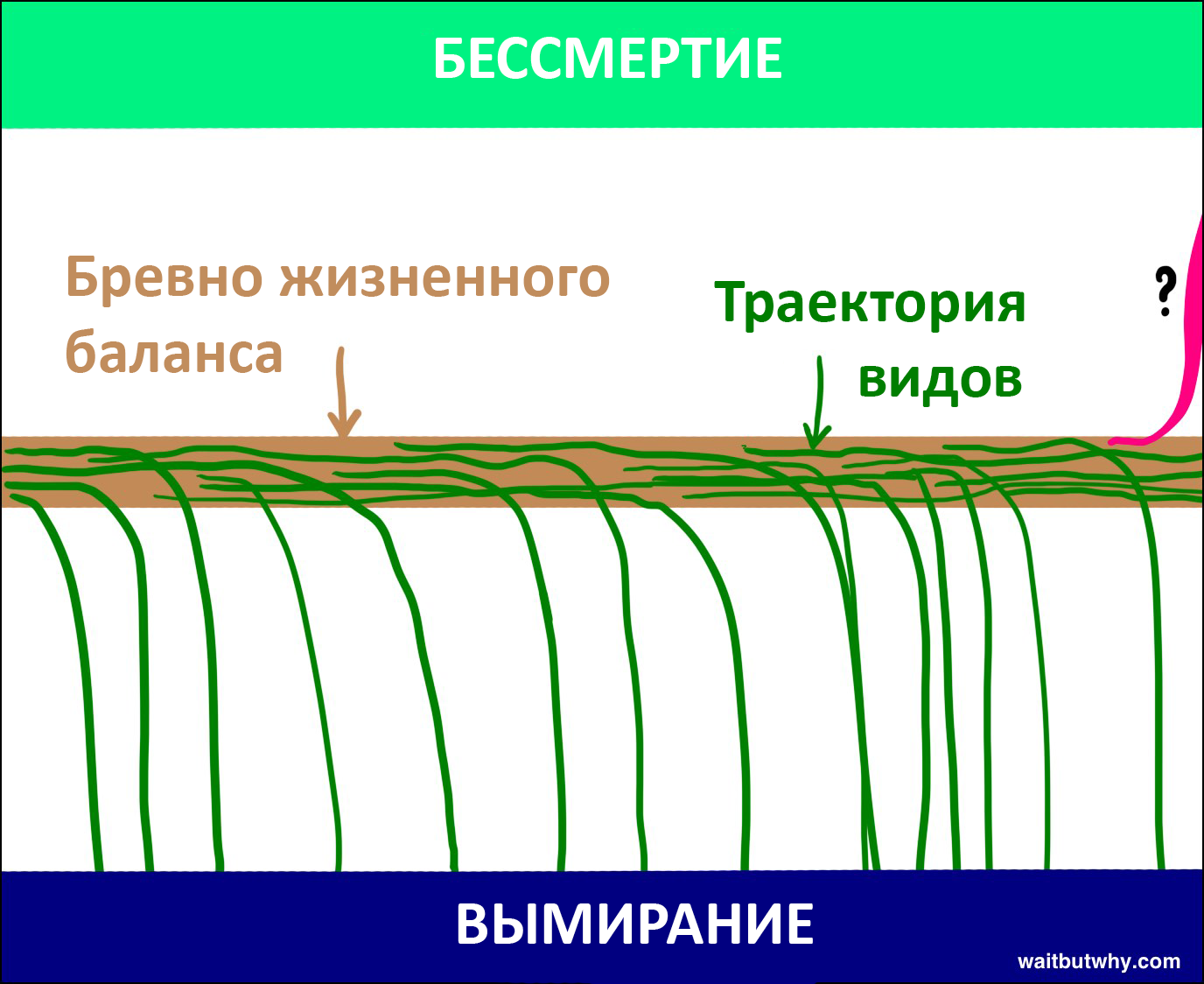

Никто в этом мире, и уж точно не я, не сможет ответить вам на этот вопрос. Но Оксфордский профессор философии и лидирующий исследователь в области искусственного интеллекта, Ник Бостром считает, что мы можем свести все варианты событий в две широкие категории. Во–первых, взглянув на историю, мы видим, что жизнь устроена следующим образом: новый вид появляется, существует какое–то время и потом неизбежно теряет равновесие и сваливается с бревна жизни, оказываясь в зоне вымирания:

«Все виды в конечном счете вымирают» — было почти таким же надежным правилом, как и «все люди умирают». Пока что 99.9 % живых существ не удержали свое равновесие и сорвались с бревна. Отчетливо ясным кажется, что находясь на грани вымирания и из последних сил цепляясь за это бревно, вид может быть легко сброшен любым катаклизмом или появлением нового вида. Ник Бостром называет вымирание аттрактором — состоянием, в которое попадают все существа и никогда из него не возвращаются обратно. Хотя большинство ученых, с работами которых я сталкивался, считают, что появление ASI обречет человечество на вымирание, многие все же верят, что при грамотном использовании ASI может привести отдельных людей или весь вид ко второму состоянию аттрактора – бессмертию вида. Бостром убежден, что бессмертие вида, как и его вымирание, представляет собой состояние аттрактора. Как только мы достигнем его, мы навсегда победим смерть. Таким образом, несмотря на то, что все виды до сих пор падали в сторону зоны вымирания, Бостром считает, что у бревна есть два края и никто на Земле еще не был достаточно умен, чтобы понять, как свалиться в другую сторону.

Если Бостром и те, кто с ним согласны, действительно правы, а судя по всему тому, что я успел прочесть, у них есть все шансы оказаться таковыми, то нам предстоит принять два шокирующих факта:

1) Появление ASI впервые откроет для видов возможность свалиться с бревна жизни в сторону бессмертия, а не вымирания.

2) Появление ASI окажет такое огромное влияние на жизнь человечества, что, скорее всего, столкнет человеческий вид с бревна жизни в ту или иную сторону.

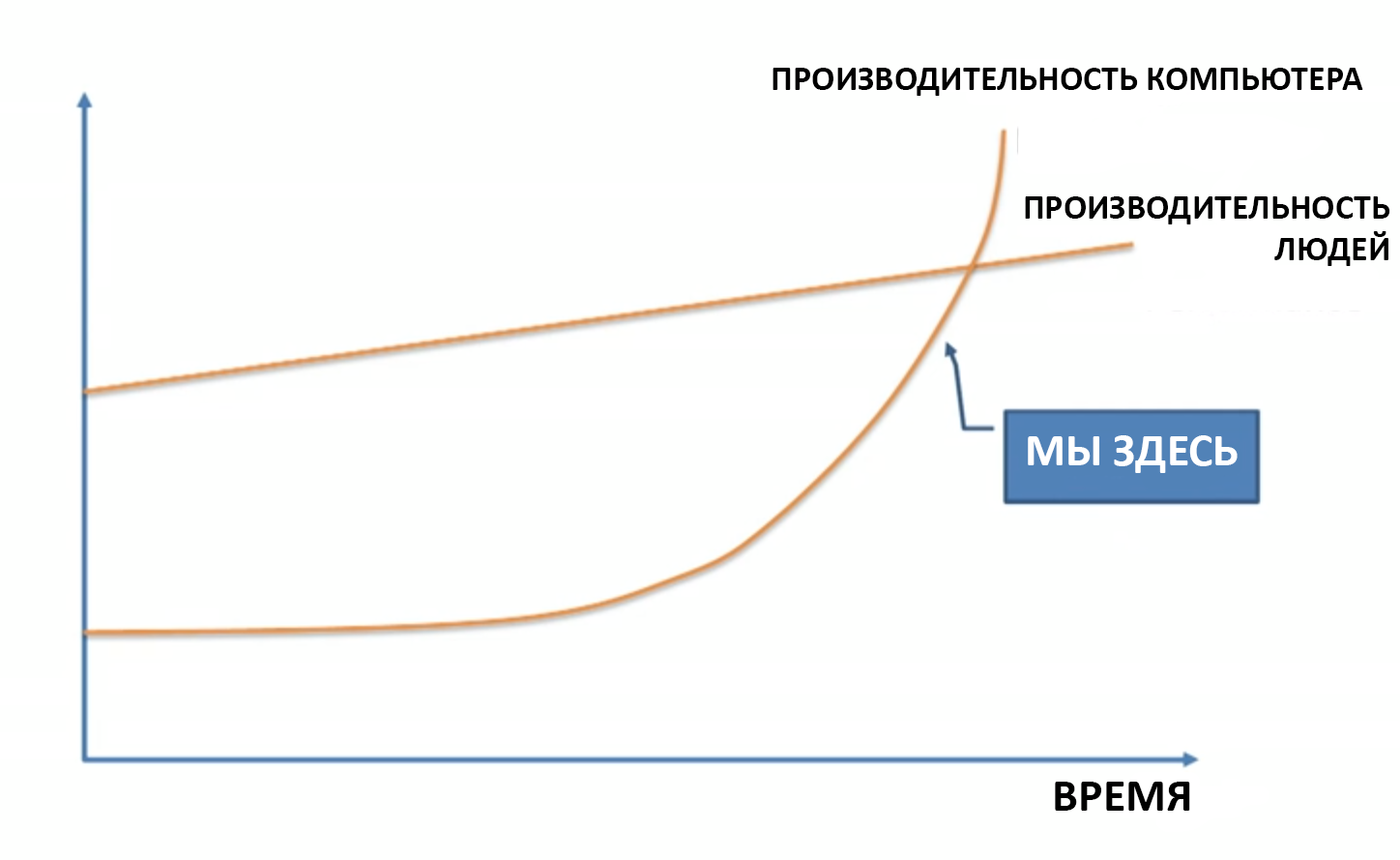

Очень вероятно, что когда процесс эволюции подведет нас к этой бомбе, взрыв навсегда положит конец человеческой связи с бревном баланса и создаст новый мир с людьми в нем или без них. Кажется, единственный вопрос, которым нам следует задаваться сейчас, — в какую сторону мы свалимся с бревна баланса, когда наступим на эту бомбу и, собственно, когда это все произойдет? Никто точно не знает, но многие ученые потратили кучу своих сил и времени, размышляя над этим вопросом. Оставшуюся часть поста мы потратим на исследование результатов их деятельности. Начнем с первой половины вопроса: когда мы наступим на бомбу? Как долго придется ждать, пока машины достигнут уровня сверхинтеллекта? Неудивительно, что оценки приводятся совершенно разные, и среди ученых ведутся жаркие споры по этому поводу. Многие, как профессор Вернор Виндж, ученый Бен Гёрцель, соучредитель компании Сан Майкросистемс Билл Джой и более известный изобретатель и футуролог Рей Курцвейл согласились с экспертом машинного обучения Джереми Говардом, когда тот представил следующий график на Ted Talk:

Все эти люди убеждены, что это произойдет скоро – экспоненциальный рост в действии, машины становятся все умнее, и, хотя пока этот процесс кажется медленным, мы и опомниться не успеем, как они уже нас обгонят через несколько десятилетий. Другие вроде соучредителя Microsoft Пола Аллена, психолога исследований Гари Маркуса, ученого Нью–Йоркского университета Эрнеста Дэвиса и технопредпринимателя Митча Капора считают, что ученые, подобные Курцвейлу, значительно недооценивают масштабы задач, и мы не так уж и близки к взрыву. Лагерь Курцвейла, напротив, считает, если что–то и недооценивается, так это экспоненциальный рост, и сравнивает сомневающихся с теми, кто, глядя на развитие интернета в 1985 году, говорили, что глобальная сеть не окажет большого влияния на мир в ближайшем будущем. Третий лагерь во главе с Ником Бостромом убежден, что ни у первых, ни у вторых нет достаточных оснований быть уверенными в своих прогнозах и считает, что: А — это может произойти в ближайшем будущем; Б — это может затянуться, и на значительно больший срок. Конечно же, есть и такие, в их числе философ Хьюберт Дрейфус, которые считают, что все три лагеря наивны и глубоко заблуждаются: никакой бомбы нет и быть не может, т.к. создание ASI невозможно. Что мы получим сложив вместе все эти точки зрения вместе? В 2013 году в ходе ряда конференций Ник Бостром провел опрос, в котором участвовали сотни экспертов в сфере искусственного интеллекта. Всем им нужно было дать ответ на один вопрос: “Когда, по вашему мнению, будет создан искусственный интеллект человеческого уровня?” Им нужно было дать оптимистичное предположение (есть шанс в 10%), правдоподобный прогноз (50% уверенности) или безопасную догадку (год, в котором уже с 90% вероятностью будет создан AGI).

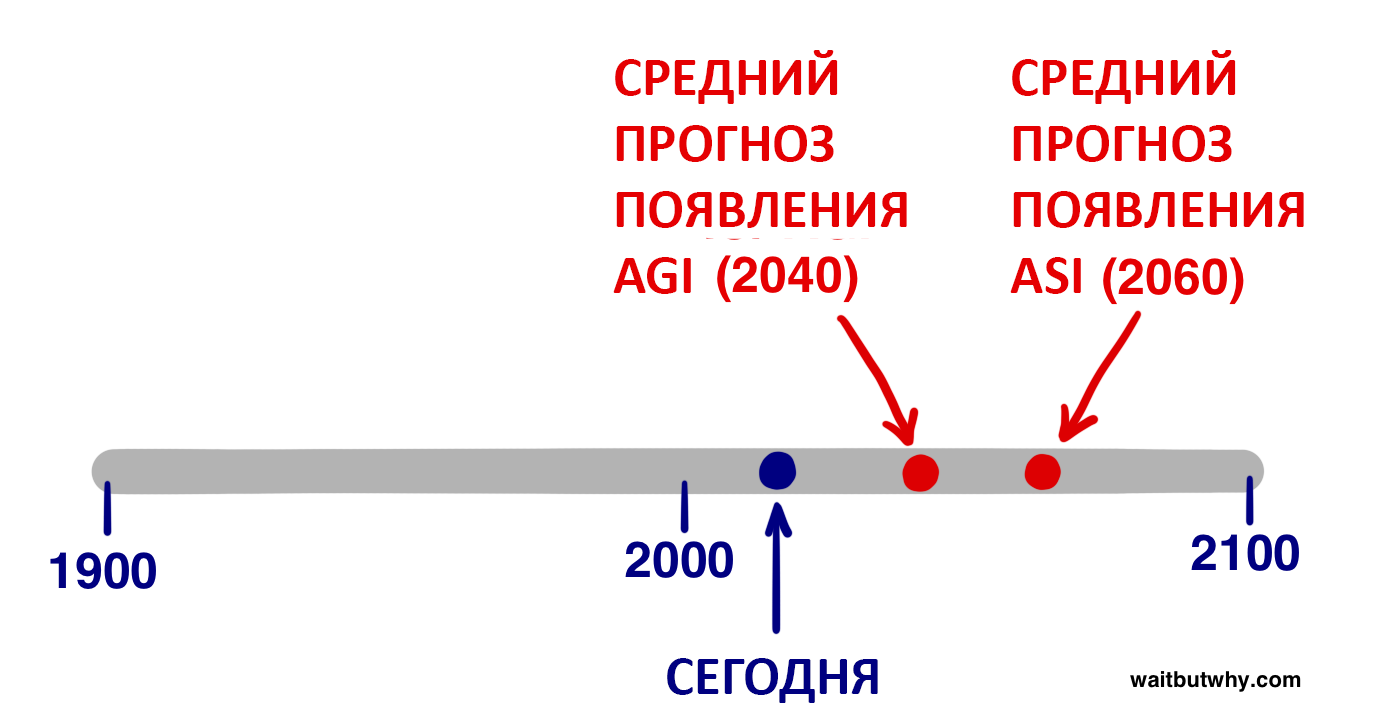

Вот результаты собранных и обработанных данных:

Средний оптимистичный год (вероятность 10%): 2022

Средний реалистичный год (вероятность 50%): 2040

Средний пессимистичный год (вероятность 90%): 2075

В среднем опрошенные считают, что, скорее всего, через 25 лет AGI станет реальностью.

Если вы подросток, то, согласно пессимистическому прогнозу, AGI точно появятся уже при вашей жизни. Отдельное исследование недавно провел писатель Джеймс Баррат на ежегодной конференции Бена Гёрцеля, посвященной AGI. В опросе Баррат предлагал участникам выбрать из списка год, когда будет создан AGI. Варианты предлагались следующие: 2030, 2050, 2100, позже и никогда.

Вот результаты: К 2030: 42 % опрошенных

К 2050: 25 % К 2100: 20 %

После 2100: 10 %

Никогда: 2 %

Эти результаты достаточно схожи с теми, что получил Бостром. В опросе Баррата больше 2/3 участников заявили, что AGI появится к 2050 году и чуть меньше половины считают, что это произойдет в течение следующих 15 лет. Поражает также, что всего 2 процента вообще не верят в достижение AGI. Но помните, что не AGI должен вызвать взрыв, а последующий за ним ASI. Кода же, по мнению ученых, появится ASI? Бостром также спросил у экспертов, когда, по их мнению, мы достигнем сверхинтеллекта, предложив следующие варианты ответа: А) в течение 2 лет (т.е. интеллектуальный взрыв последует почти незамедлительно) после изобретения AGI; Б) в течение 30 лет. Теперь смотрим результат: По результатам среднего прогноза, возможность резкого скачка маловероятна — всего 10% опрошенных, а более длительных переход возможен с вероятностью в 75%. Эти данные не дают нам среднего процента вероятности (50%), но с целью приблизительного прогноза, основанного на двух вышеперечисленных ответах, предположим, что они сказали “20 лет”. Согласно среднему прогнозу экспертов в области ИИ, по самому правдоподобному прогнозу мы достигнем сверхинтеллекта приблизительно к 2060 году (2040 год — появление AGI, плюс наш прогноз 20–летнего перехода от AGI к ASI).

Конечно, все вышеперечисленные статистические данные спекулятивные и представляют собой только среднее мнение среди экспертов в области ИИ, но они показывают, что большинство людей, которые лучше всех осведомлены в этой теме, согласились бы, что 2060 – достаточно разумное предположение для года, когда появится сверхинтеллект, который изменит мир. От этого момента нас отделяет всего 45 лет. Хорошо, теперь насчет второй части вопроса – с какого края бревна мы свалимся, когда произойдет взрыв? Сверхинтеллект будет обладать огромной мощью, и критическим для нас станет следующий вопрос:

Кто будет контролировать эту мощь и какая у него будет мотивация?

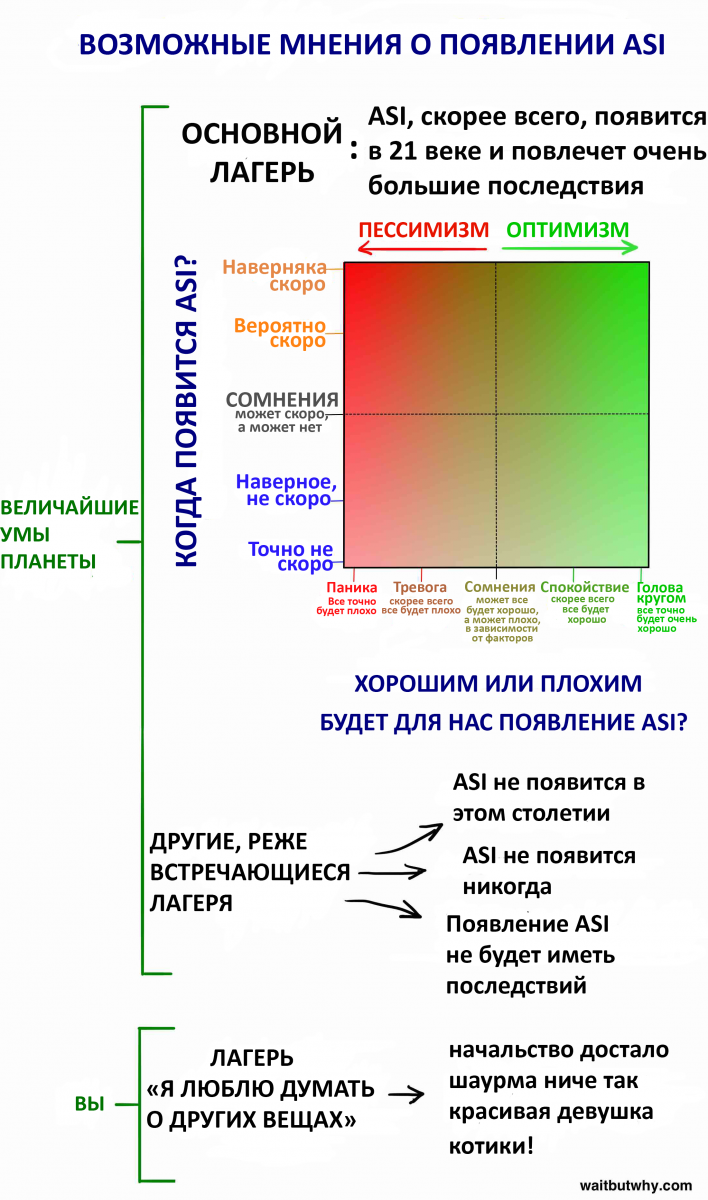

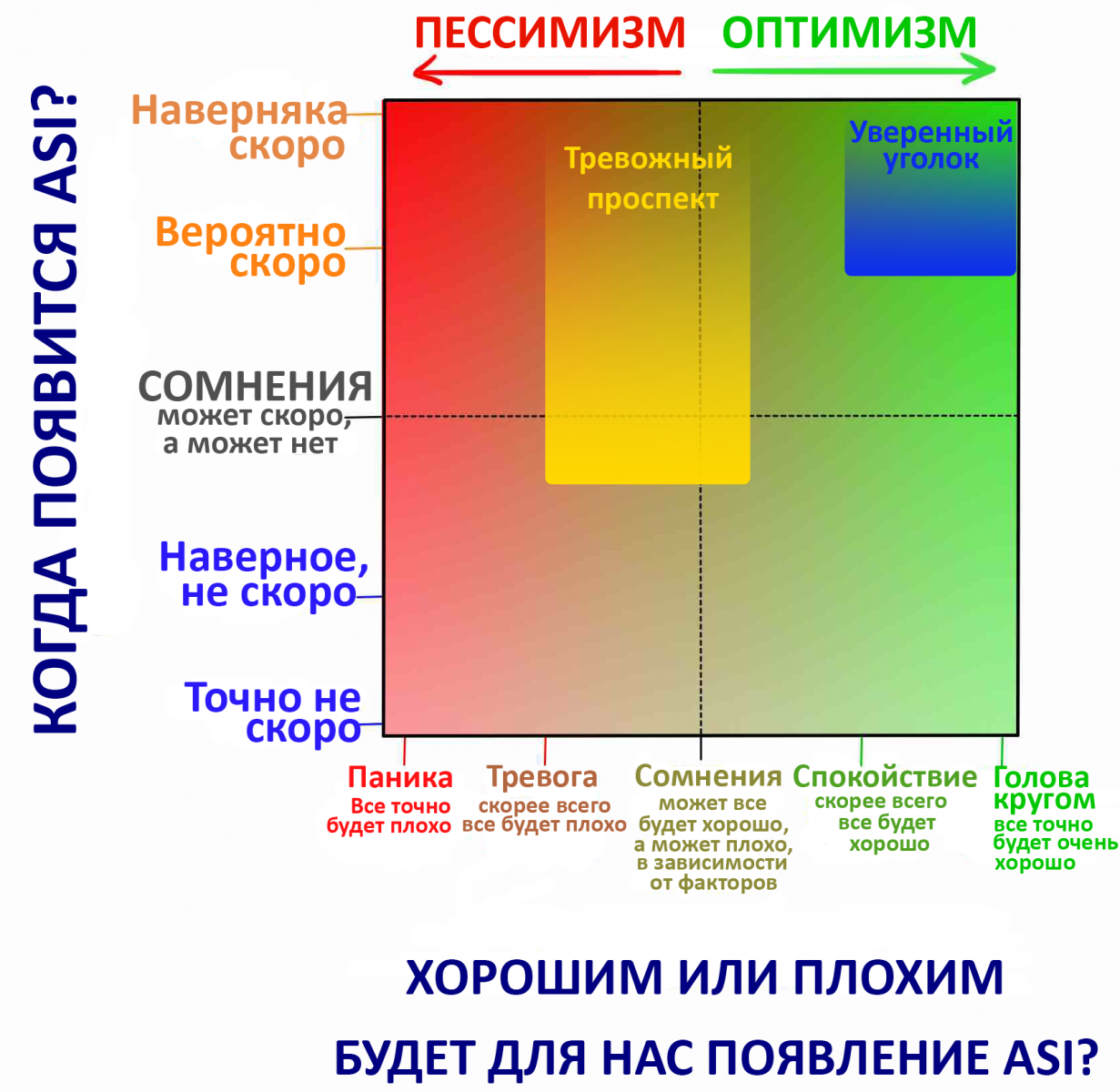

В зависимости от ответа на него, мы решим, должен ли ASI вызывать у нас восхищение или страх. Конечно же, научное сообщество и здесь существенно расходится в мнениях и ведет жаркие споры. В опросе Бострома участникам предлагалось оценить вероятность возможных последствий влияния AGI на человечество: 52% считают, что последствия будут хорошими или даже очень хорошими; 31% считают, что последствия будут плохими или очень плохими. Только 17% посчитали, что последствия будут нейтральными. Иными словами, люди, которые лучше всего осведомлены в этой теме, уверены, что это все это очень серьезно. Следует заметить, что речь здесь шла только об AGI, если бы вопрос был об ASI, процент с нейтральной оценкой, вероятнее всего, был бы намного ниже. Пока мы еще полностью не углубились во всю эту риторику хороших и плохих последствий, давайте пока объединим обе части вопроса «когда это случится?» и «будет ли это чем–то плохим или хорошим» в один график, который включает в себя мнения большинства соответствующих экспертов:

Скажите, определились ли вы со своей позицией? На самом деле, я знаю, что вы скажете, потому что я считал так же, пока не углубился в исследование этого вопроса. Некоторые причины, по которым люди не особо задумываются над этой темой: Как мы уже говорили фильмы существенно запутали нас, показывая нереалистичные сценарии развития ИИ, заставляя нас думать, что ИИ не является чем–то, что стоит воспринимать всерьез. Джеймс Баррат сравнивает подобную реакцию с тем, как если бы центры по контролю и профилактике заболеваний сделали бы серьезное предупреждение о надвигающейся опасности наступления эпидемии зомби. Это называется когнитивными предрассудками, нам тяжело поверить в реальность чего–то, пока мы не увидим доказательства этому. Я уверен, что ученые в 1988 постоянно обсуждали насколько серьезным будет развитие интернета, но люди не задумывались о том, как он изменит их жизнь, пока этого не произошло. Отчасти так было из–за того, что компьютеры в 1988 году не были столь функциональны, и глядя на них, люди не верили, что те скоро изменят их жизни. Их воображение было ограничено личным опытом и не позволяло отчетливо представить себе, чем могут стать компьютеры. То же самое происходит сейчас и с ИИ. Мы слышим, что это все очень серьезно, но наш опыт, которому известны только относительно слабые ИИ, усложняет для нас возможность поверить в коренные перемены, которые привнесет сверхинтеллект. С такими предрассудками и борются эксперты, пытаясь отвлечь наше внимания от ежедневного шума нашего эго. Даже если бы мы и поверили – сколько раз за день вы задумываетесь о том, что проведете большую часть вечности в небытии? Не так много, верно? Хотя этот факт значимее любого из ваших повседневных занятий. Наш мозг концентрируется в основном на более мелких обыденных задачах, независимо от того, насколько безумной является долгосрочная ситуация, в которой мы находимся. Просто мы так устроены. Одна из целей этого поста — переманить вас из лагеря «Я люблю думать о других вещах» в один из экспертных лагерей, даже если вы просто стоите в абсолютной неуверенности на пересечении двух пунктирных линий в нижней диаграмме. В ходе этого исследования я наткнулся на десятки различных мнений по данному вопросу, но быстро заметил, что их все можно объединить в один основной лагерь и, в частности около ¾ экспертов попали в два подлагеря внутри основного:

https://interpreted.dirty.ru/perevod-revoliutsiia-iskusstvennogo-intellekta-684922

Комментарии (0)