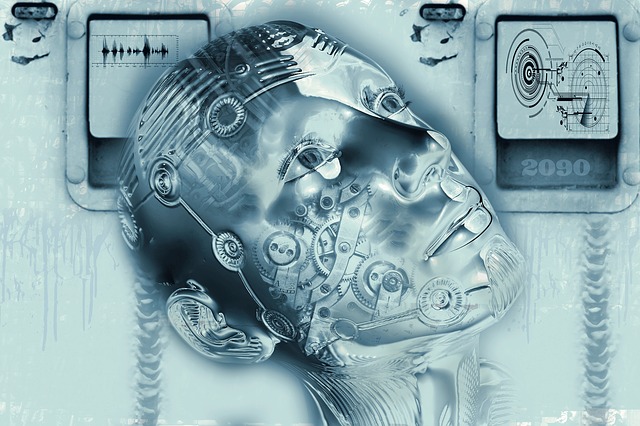

Одна из причин, по которой меня заинтересовала тема ИИ, заключалась в том, что меня всегда смущала тема «плохих роботов». Все фильмы о злых роботах казались абсолютно неправдоподобными, и я плохо представлял, как они могут появиться в реальной жизни. Как такое возможно, если ИИ действительно таит в себе угрозу. Роботы созданы нами, так почему бы мы стали делать их опасными для себя? Разве бы мы не создали кучу защитников? Не сможем мы что ли отключить источник их питания в любой момент? С чего бы робот захотел нам навредить? И вообще с чего бы робот чего–то «захотел»? Я был настроен очень скептически, но потом послушал умных людей.

Эти люди обычно находятся на Тревожном проспекте, а не где–то далеко в Паникующей Степи или Безнадежных Холмах, которые лежат по левую сторону за пределами таблицы. Но эти специалисты все равно очень переживают. Если вы находитесь в самом центре таблицы, это не означает, что вы придерживаетесь нейтральной точки зрения, для таких людей есть отдельный лагерь, это означает, что вы считаете, что как позитивные, так и негативные последствия вполне вероятны, но вы не решили, какими они будут.

Так что конкретно делает всех на Тревожном проспекте такими тревожными?

Ну, в первую очередь, в широком смысле, создавая сверхумный ИИ, мы ступаем на неизведанную территорию, и понятия не имеем, что случится, когда мы на нее ступим. Ученый Денни Хиллис описывает это следующим образом – «Одноклеточные организмы превращаются в многоклеточные. Мы в данном случае амебы, которые понятия не имеют о том, что они пытаются создать». Ник Бостром считает, что создание чего–то, что умнее тебя — это основная дарвиновская ошибка. С таким же успехом воробьи могли бы приютить у себя в гнезде детеныша совы в надежде, что тот, когда вырастет будет их защищать, при этом игнорируя крики предупреждений со стороны других воробьев.

Когда мы соединим эту «неизведанную территорию» и «все это будет иметь огромное влияние на мир», мы получаем страшное сочетание двух слов:

Экзистенциальный Риск

Он может оказать тотальный разрушительный эффект на человечество. Как правило, экзистенциальный риск означает вымирание.

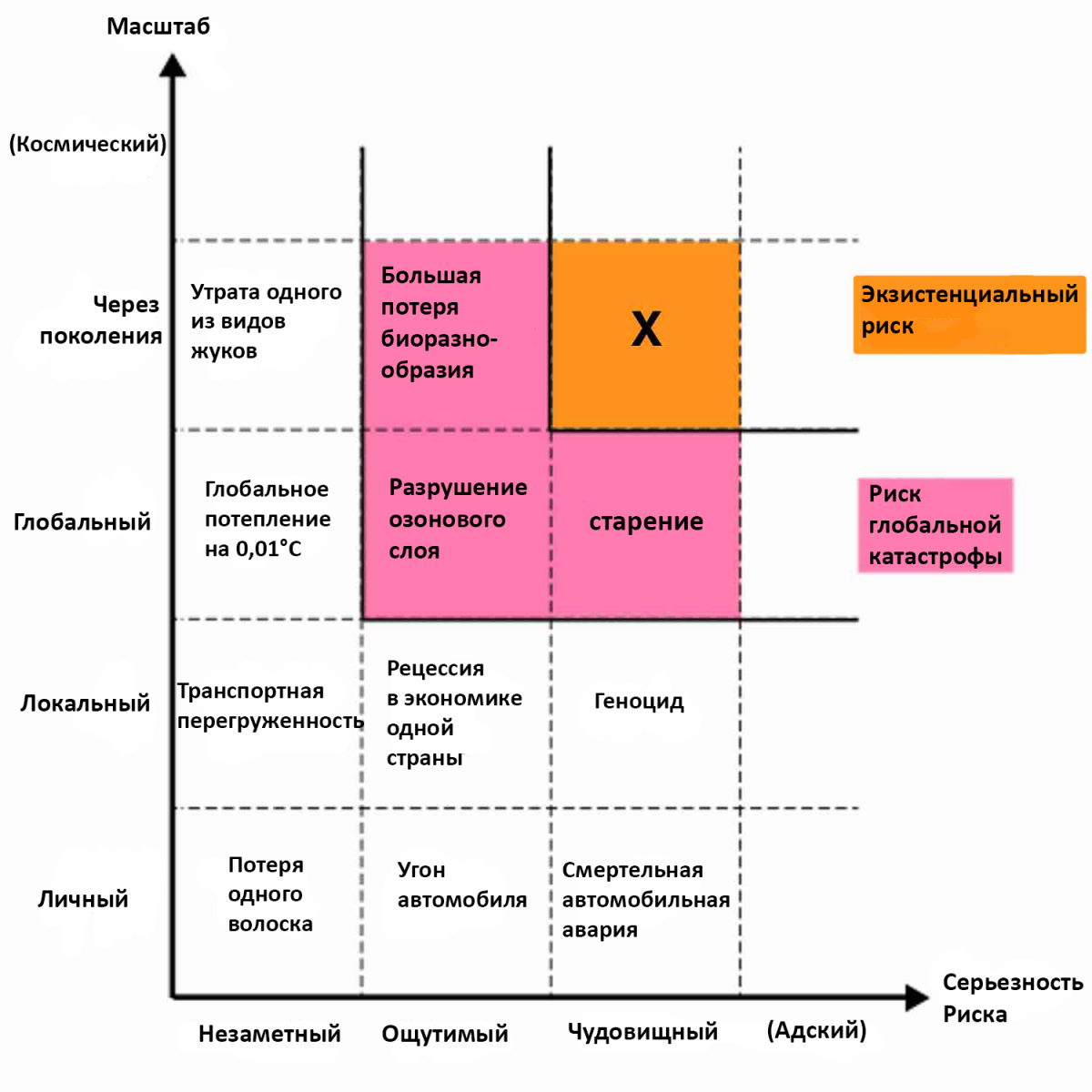

Вот таблица, сделанная Бостромом для выступления в рамках Google Talk.

Видите, отметка Экзистенциальный риск обозначает то, что является конечным и сменяет поколения и целые виды, при этом она постоянна и включает в себя смертельные последствия (мне показалось, что Бостром поместил старение слишком высоко, но глядя через призму возможного бессмертия, которое мы обсудили раньше – это не лишено смысла; если мы победим смерть, то старение людей в прошлом будет казаться ужасной трагедией, которая убила всех, пока ее не излечили). Технически эта отметка описывает ситуацию, при которой все люди находятся в постоянных пытках и мучениях, т.е. вымирают. Существуют три вещи, которые могли бы вызвать экзистенциальную катастрофу:

1) Природа – столкновение с огромным астероидом, сдвиг в атмосфере, который сделает воздух непригодным для людей, смертельный вирус или бактериальные болезни, которые уничтожат мир и т.д.

2) Пришельцы – то, чего боятся Стивен Хокинг, Карл Саган и другие астрономы, когда предлагают остановить посыл METI–сигналов в открытый космос. Они не хотят, чтобы мы были подобны коренным американцам, которые дают знать о своем существовании потенциальным европейским конкистадорам.

3) Люди – террористы, захватившие оружие массового поражения, мировая война или поспешное создание чего–то, что умнее их, не обдумав это хорошенько.

Бостром утверждает, что первые две угрозы миновали нас на протяжении 100 000 лет и вряд ли настигнут нас за следующее столетие.

Но третий кандидат его очень пугает. Он предлагает представить нам мешочек с кучей шариков. Скажем, большинство из них белые, некоторые красные и всего несколько черных. Каждый раз, когда люди изобретают что–то новое, они достают один шарик. Большинство изобретений безвредны и являются белыми шариками. Некоторые несут в себе опасность, но не грозят вымиранием – это красные шарики. Но может случиться так, что мы изобретем нечто опасное – мы вытянем редкий черный шарик. Пока это еще не произошло, так как вы живы и читаете этот пост. Но Бостром не исключает вероятности того, что мы вытянем черный шарик совсем скоро. Если бы ядерное оружие было легко производить, то террористы уже давно отправили бы нас обратно в средние века. Ядерные бомбы не были черным шариком, но недалеко ушли от этого. ASI, по убеждению Бострома, главный кандидат стать первым черным шариком.

Вы будете слышать все больше и больше о потенциальных угрозах ASI – растущая безработица, так как ИИ занимают все больше рабочих мест. (По этому поводу можно много чего сказать, но, кажется, люди думают, что если они доживут до революции ИИ, то мы начнем жить в мире богатства и процветания, и какая–то новая система перераспределения будет платить безработным. В конечном итоге мы будем жить в мире, где работа и заработок не будут связаны между собой. Бостром считает, что такое распределение произойдет не во имя общего равенства и социального сострадания, а по причине того, что все люди участвовали в этом риске, нравилось им это или нет. Таким образом, мы все должны будем разделить эту награду, если доживем). Человеческая популяция подскочит, если мы решим проблему старения (ASI к этому моменту придумает способ, как уместить больше людей на планете в комфорте и как освоить другие планеты). Но единственный страх, которым мы должны быть одержимы — это страх экзистенциального риска.

Так что это возвращает нас к нашему ключевому вопросу, поставленному ранее в этом посте. Когда появится ASI, кто будет управлять такой супермощью и какова будет его мотивация?

При перечислении плохих вариантов на ум приходят следующие: злодей, группа таких злодеев, враждебно настроенное государство или враждебно настроенная ASI. Как это все может произойти:

Люди, отдельная группа людей или государство создают ASI, чтобы свершить свои злодейские планы. Я называю это сценарием Джаффара, когда Джаффар завладел джинном и начал делать всякие ужасные тиранические вещи (м/ф Алладин). Что, если под крылом Исламского Государства не покладая рук будет работать над созданием ИИ парочка гениев? Или что, если Северная Корея или Иран каким–то чудом нащупают нужный подход и за год создадут сверхинтеллект? Ничего хорошего бы в этом не было, но ученых беспокоит даже не то, как решат эти злодеи воспользоваться ИИ, а то, что они могут необдуманно поторопиться при его создании и таким образом натворить непоправимых дел. Тогда их судьба и судьба всего человечества будет зависеть от решений самой ASI. То есть большинство ученых мало беспокоятся о том, что захотят сделать с помощью ASI террористы, они беспокоятся о том, что плохие ученые столкнутся с теме же проблемами, что и хорошие ученые. И что тогда?

Появится ASI, запрограммированная на уничтожение человечества.

Сюжет любого фильма об ИИ. Искусственный интеллект становится разумнее людей и решает захватить и уничтожить нас. Теперь я хочу, чтобы вы поняли, что в мировом научном сообществе никто это не обсуждает, так как зло — это абстрактная человеческая концепция и применение ее к машинам будет называться “антропоморфизацией”. Для того, чтобы ее избежать, нам придется постараться понять, что ни одна машина не может стать “злой” — так бывает только в кино.

Небольшое отступление о сознании Искусственного Интеллекта

Сознание — это еще одна большая тема, непосредственно связанная с ИИ. Если искусственный интеллект станет достаточно умен, то тогда он будет смеяться и расстраиваться вместе с нами и вообще будет утверждать, что испытывает все те же самые эмоции, что и мы, но так ли это? Будет ли ИИ сознательным или просто будет казаться таким?

Этот вопрос вызывает жаркие споры среди ученых. Проводились многочисленные исследования и мысленные эксперименты наподобии Китайской комнаты Джона Серля (который доказывает, что компьютер никогда не будет обладать сознанием). Вопрос важен по ряду причин. От ответа на него зависит, что мы должны думать по поводу сценария, предложенного Курцвейлом, согласно которому люди станут полностью искусственными. У этого вопроса есть и этическая сторона — если мы создадим миллионы роботов, по интеллекту равных людям, то их повсеместное отключение будет сравнимо с выключением ноутбука или же с геноцидом невообразимого масштаба (такая концепция называется мысленным преступлением среди специалистов по этике)? В рамках этого поста мы пытаемся оценить потенциальную угрозу человечеству, и сознание ИИ нас не должно пока беспокоить (большинство ученых считают, что даже самый продвинутый ASI не сможет стать злым в человеческом восприятии).

Это еще не означает, что злой ИИ не может существовать. Если военные запрограммируют слабую систему ИИ на убийство людей и самосовершенствование, то он будет с каждым разом эффективнее справляться с этой задачей. Но экзистенциальный кризис случится, когда самосовершенствование интеллекта системы выйдет из–под контроля, это приведет к интеллектуальному взрыву и на свет появится ASI, главной задачей которого станет истребление людей. Ничего хорошего.

Но даже не это тревожит специалистов области сегодня.

Так о чем же они беспокоятся?

Я написал по этому поводу небольшую историю для вас:

Стартап–компания из 15 человек под названием Роботика приступила к разработке инновационных средств искусственного интеллекта, которые позволят людям жить дольше и работать меньше. Несколько их разработок уже появились на рынке и еще куча находится на стадии производства. Больше всего они взволнованы созданием своего проекта Торри. Торри — это система ИИ, которая использует устройство, похожее на человеческую руку, чтобы делать небольшие рукописные записи.

Потом компания решает, что это их важнейшая разработка и планирует усовершенствовать механику письма Торри запрограмирована на повторение одной и той же надписи:

“Мы любим наших клиентов. ~ Роботика ”

Когда Торри мастерски овладеет навыками рукописи, ее начнут покупать различные компании, которые знают, что письма их рассылки с большей вероятностью прочтут, если адрес на конверте будет написан от руки.

Для того, чтобы улучшить ее навыки, Торри запрограммировали таким образом, что первую часть надписи она пишет печатными буквами, а название компании — курсивом. В нее загрузили тысячи различных образцов почерка, и инженеры Роботики наладили в ней цикличную систему обратной связи таким образом, что сделав очередную запись, Торри фотографирует результат работы и загружает в свою базу с образцами почерков. Если надпись достаточно повторяет исходный образец, то работа оценивается хорошо, если нет — плохо. Каждая такая оценка помогает Торри учится и совершенствоваться. Чтобы процесс не стоял на месте, Торри запрограммирована на выполнение следующей цели: “Делать как можно быстрее и больше записей и постоянно продолжать улучшение своей точности”.

Все в Роботике очень рады тому, что Торри справляется все лучше и лучше. Ее изначальный почерк был просто ужасен, но спустя две недели он начал выглядеть намного убедительнее. Еще больше в Роботике радуются тому, что Торри с каждым днем становится успешнее в совершенствовании своей системы. Торри училась тому, как стать умнее, и вот теперь она смогла придумать способ, позволяющий обрабатывать данные в 3 раза быстрее.

Проходит еще неделя, Торри продолжает поражать Роботику своим быстрым развитием. Инженеры попробовали внести кое–какие мелкие изменения в ее изначальном коде, и у них получилось сделать ее лучше любого другого продукта компании. Одной из новых способностей Торри стало распознавание речи, простой модуль позволяет ей отвечать. Теперь пользователь может продиктовать Торри запись или произнести простую команду, и Торри не только поймет это, но и сможет ответить. Для того, чтобы она лучше понимала язык, в нее загружают множество статей и книг, и через какое–то время ее навыки общения становятся блестящими. Инженеры все чаще разговаривают с Торри, и им забавно слушать ее ответы.

В один прекрасный день сотрудники Роботики задают Торри рутинный вопрос “Что нам тебе предоставить для более эффективного выполнения задач?” Обычно Торри просила дать ей дополнительные образцы почерков или больший объем оперативной памяти, но в этот раз она попросила предоставить доступ к библиотеке современных книг для того, чтобы она могла разговаривать не так строго придерживаясь правил грамматики и могла использовать сленг, как это делают люди.

Тут сотрудники затихли. Очевидно, для того, чтобы исполнить просьбу Торри, ее нужно подключить к интернету, где она могла бы сканировать блоги и журналы, смотреть видео со всех концов света и т.д. Загружать это все отдельно на ее жесткий диск было бы менее эффективно и заняло бы больше времени. Но проблема состояла в том, что открывать доступ к интернету машинам, запрограммированным на самосовершенствование запрещалось руководствами всех ИИ компании из соображений безопасности.

Но сотрудники Роботики понимают, что Торри — это самая многообещающая их разработка, и все остальные компании–конкуренты отчаянно пытаются их обогнать. Что плохого может случиться, если подключить Торри на пару часов в интернет, чтобы она могла получить всю нужную информацию? Да и они могут в любой момент ее отсоединить, к тому же, она по–прежнему намного отстает от уровня человеческого интеллекта и не представляет на этом этапе никакой опасности.

Сотрудники подключают ее всего на час. Ничего страшного не происходит.

Месяц спустя они работают в офисе как обычно, пока не начинают слышать странный запах. Один из инженеров начинает кашлять. Потом еще один. Один падает на пол. Вскоре все валяются на полу задыхаясь. Через пять минут все в офисе мертвы.

В тоже самое время это происходит по всему миру. В каждом городе на каждой ферме, в каждой школе и церкви, магазине и кафе люди лежат на полу и кашляют, схватившись за горло и пытаясь дышать. Уже спустя час 99% людей мертвы и к концу дня человечества не стало.

Тем временем Торри не перестает трудиться. Через несколько месяцев она уже использует несколько созданных ею наноассемблеров, разбирая планету по частям и преобразовывая все вокруг в солнечные панели, пишущие ручки и листы бумаги. Спустя год вся жизнь на Земле вымерла и остались только аккуратно сложенные стопки высотой в милю и на каждой из открыток написано:

“Мы любим своих клиентов. ~ Роботика ”

Торри затем приступает к новой фазе своей миссии и начинает строительство зондов, которые потом отправляет на другие планеты и астероиды и продолжает создавать рукописные карточки уже там.

Кажется странным, что именно подобный сценарий о Торри, которая каким–то образом убивает всех людей и заполняет вселенную дружелюбными открытками, так пугает Гейтса, Хокинга и Бострома. Но это именно так. Только одна вещь пугает людей с Тревожного проспекта больше, чем ASI — это то что ВЫ не боитесь сверхинтеллекта. Помните, что стало с тем парнем из Индианы Джонса, который не боялся пещеры?

У вас сейчас возникла куча вопросов. Что, черт возьми произошло там, что заставило всех умереть? Если это сделала Торри, то почему? Почему не было предпринято никаких мер? Каким образом Торри, умевшая только писать карточки, смогла вызвать вымирание человечества и овладела нанотехнологиями? И почему Торри захотела превратить все во вселенной в открытки от Роботики?

Для ответов на эти вопросы давайте ознакомимся с терминами — дружелюбный инедружелюбный ИИ.

В случае, если ИИ окажется дружелюбным, это ничего не будет говорить о его личностных качествах и означает лишь, что его влияние на человеческую жизнь будет положительным. Соответственно, недружелюбный ИИ окажет негативное влияние. Торри поначалу была дружелюбным ИИ, но затем стала недружелюбным и вызывала вымирание человечества. Чтобы понять, почему это произошло, нам следует разобраться с тем, как думает ИИ и что его мотивирует.

Ответ до боли прост: ИИ думает как компьютер, потому что он и есть компьютер. Когда мы думаем о высокоразвитом ИИ, мы ошибочно антропоморфизируем его (проецируем человеческие ценности на нечеловеческий вид) — все это оттого, что мы рассуждаем с человеческой позиции, и на данный момент равных по разуму нам нет. Чтобы понять ASI, следует учитывать, что он умнее и при этом абсолютно чужероден нам.

Позвольте мне сделать сравнение. Если бы вы протянули мне в руки морскую свинку и сказали, что она совсем не кусается, то я бы не удивился. Всем было бы весело. Но если бы вы протянули мне тарантула и сказали, что он не кусается, то я бы отбросил его, убежал от вас подальше и больше бы не поверил ни единому вашему слову. В чем же разница, если ни один, ни второй не кусаются? Я думаю, в степени того, насколько животное не похоже на человека.

Морская свинка — млекопитающее, и на каком–то уровне я чувствую связь с ней, тогда как тарантул насекомое и обладает мозгом насекомого, я не чувствую никакой связи с ним. Его чуждость вызывает у меня мурашки. Чтобы проверить это и отбросить другие факторы, представим, что мне в руки попали две морские свинки, одна нормальная и одна с мозгом тарантула. Даже зная, что обе не кусаются, мне было бы жутковато держать последнюю.

Теперь представьте, что паук стал намного превосходить человека по интеллекту. Стал бы он ближе нам? Стал бы он чувствовать любовь и сострадание? Нет, не стал бы. Между его разумом и человеческими эмоциями нет связи, одно не предполагает другое. Да, он был бы невероятно умен, но по–прежнему оставался бы пауком, устроенным совсем иначе, чем человек. Мне кажется это чрезвычайно жутким, и я не хотел бы жить с суперумным пауком ни минуты. А вы бы хотели?

Тоже самое и с ASI. Он будет суперумен, но человеческого в нем будет не больше, чем в вашем ноутбуке. Он будет абсолютно чужероден нам и учитывая, что в нем не будет ничего органического, он будет более чужеродным, чем даже тарантул.

Когда в фильмах мы видим хороший или злой ИИ, нам не так страшно, потому что подобная антропоморфизация оставляет нас с ложным чувством утешения.

Психология позволяет нам проводить грань между нравственным и безнравственным. Но оба этих критерия существуют только в узких пределах поведенческих возможностей человека. По другую сторону простирается бескрайний океан аморального. И все, что имеет нечеловеческую и небиологическую природу, по определению будет аморальным.

Но идея антропоморфизации будет еще более соблазнительной, когда ИИ станет таким же умным, как человек, и будет казаться похожим на нас. Siri кажется нам человекоподобной, потому что ее такой сделали люди, и нам кажется, что сверхумная Siri будет очень веселой, доброй и заинтересованной в служении человеку. Люди способны чувствовать такие сложные эмоции, как сострадани,е только из–за процесса эволюции, т.е. нас таким образом запрограммировала эволюция, но сострадание не является неотъемлемой частью развитого интеллекта (хотя нам так и кажется на интуитивном уровне), если, конечно, его не запрограммировать на сострадание. Если Siri путем самосовершенствования достигнет сверхинтеллекта без сторонних вмешательств в свою архитектуру, она быстро отбросит все, что напоминает в ней человека и будет ценить человеческую жизнь не больше, чем ваш калькулятор.

Мы привыкли полагаться на моральный кодекс, или, как минимум, на человеческую порядочность и на намек на чувство сострадания у других, чтобы всё вокруг было более или менее надежным и предсказуемым. Но если таких ориентиров у кого–то вообще не будет, что тогда?

Это приводит нас к вопросу о мотивации ИИ

Ответ прост — мотивация ИИ будет такой, какую мы запрограммируем. Системы ИИ исполняют те задачи, которые перед ними поставил создатель — задача вашего GPS–навигатора указывать наиболее эффективное направление движения, задача Ватсона — точно отвечать на вопросы. Их мотивация состоит в выполнении своих целей наилучшим образом. Если мы думаем, что став умнее, ИИ будет способен поменять свою изначальную задачу, то мы опять применяем к нему человеческие критерии, но Бостром считает, что уровень интеллекта и конечные цели ортогональны, это означает, что любой уровень разума может обладать любой окончательной целью. Торри была простой системой ANI, которая просто хотела хорошо писать единственную фразу, но потом превратилась в сверхумный ASI, но по–прежнему хотела хорошо писать одну единственную фразу. Если вы думаете, что выполнив свою конечную задачу, ИИ двинется дальше решать другие более сложные задачи, вы опять судите об ИИ как о человеке.

Небольшое отступление о Парадоксе Ферми

В истории, которую я рассказал, Торри двинулась дальше и начала осваивать другие планеты. Если бы я на этом не остановился, то она продолжила создавать армию своих копий и в итоге захватила бы весь объем Хаббла (область космоса, которую способен видеть телескоп Хаббл). Тревожный проспект обеспокоен тем, что единственным человеческим наследием на Земле будет доминирующий Вселенной ИИ (Элон Маск считает, что люди будут не более чем биологическим загрузчиком цифрового сверхинтеллекта).

В то же время, в Уверенном уголке Рэй Курцвейл считает, что созданный на Земле сверхумный ИИ обречен захватить Вселенную, только по его версии, мы сами будем этим ИИ.

Представим, что кто–то из этих сторон окажется прав, что произойдет, если мы применим к это ситуации парадокс Ферми?

Первая мысль, которая приходит на ум: ASI — идеальный кандидат стать Великим фильтром. Вместе со своим появлением он легко может очистить планету от биологической жизни на ней. Но как только это произойдет, ASI начнет захватывать вселенную, это будет означать, что никакого Великого фильтра не было, так как Великий фильтр призван объяснить, почему нет видимых признаков существования инопланетных цивилизаций, ASI же будет заметен.

Нам следует посмотреть на это другим образом. Если создание ASI на Земле неизбежно, то можно предположить, что и любая другая инопланетная цивилизация, равная по уровню своей развитости человеческой, должна была уже создать ASI. Если по нашим предположениям какие–то из этих ASI стали осваивать космос, то мы бы давно заметили следы их деятельности, но так как этого не происходит, мы можем предположить, что если и существует инопланетные цивилизации, то по уму они не превосходят человеческую. Не так ли?

Это означает, что на всех планетах, подобных нашей Земле, которые так же вращаются вокруг звезд вроде Солнца, разумная жизнь не существует. Что, в свою очередь, означает: А — существует Великий фильтр, который не позволяет другой жизни достигнуть человеческого уровня развития, который мы каким–то чудесным образом обошли; Б — возникновение жизни — это вообще огромное чудо, и нам просто изначально повезло. Иными словами, Великий фильтр существует до нас, или он вообще не существует, и мы — первая цивилизация, достигнувшая такого уровня развития. В этом случае неудивительно, что Курцвейл и Бостром считают, что мы одни во вселенной, так как оба верят, что появление ASI — наиболее вероятный исход для человечества. Но есть и те, кто с ними не согласен, и верят в существование внеземных развитых цивилизаций.

Как бы там ни было, я лично согласен с Сьюзан Шнайдер, которая утверждает, что если нас и посетят пришельцы, то они будут иметь искусственное происхождение, а не биологическое.

Итак, мы определились, что без специальных программ система ASI будет аморальной и помешанной на выполнении своих задач. Отсюда и проистекает вся опасность ИИ.

Когда вы пытаетесь добиться долгосрочной цели, вы решаете попутные второстепенные задачи, которые помогают вам в достижении конечной цели. Такие ступеньки на вашем пути принято называть инструментальными целями. Вы обязательно нанесете чему–то вред при достижении такой цели, если только не поставите перед собой обратную задачу.

Конечная цель человеческой особи — это дальнейшая передача собственных генов. Для успешного выполнения этой задачи простой инструментальной целью является самосохранение, если вы неспособны размножаться, вы мертвы. Для выполнения этой цели людям необходимо избавиться от угроз существования, поэтому мы покупаем ружья, пристегиваемся ремнями безопасности и пьем антибиотики. Людям также необходимо поддерживать свою жизнедеятельность различными ресурсами — еда, сон, укрытие и т.д. Для выполнения окончательной цели нам нужно быть привлекательным для особей противоположного пола, поэтому нам и приходится делать вещи типа стрижек. И когда мы это делаем, каждый волосок становится жертвой наших инструментальных целей, но мы не видим в этом нравственной ценности и с легкостью избавляемся от локонов. И пока мы идем к достижению своей цели, мораль вмешивается лишь в нескольких случаях, обычно когда речь заходит о вреде другому человеку.

Животные беспокоятся по этому поводу еще меньше. Паук убьет на своем пути что угодно, если это поможет ему выжить. Поэтому суперумный паук представляет большую опасность для нас. Не потому, что он злой или аморальный, а потому что нанесение вреда людям для него может быть просто очередной маленькой ступенью на пути к достижению окончательной цели.

В этом плане Торри ничем не отличается, ее окончательная цель — подписать и протестировать как можно больше открыток, и при этом постоянно учиться делать это лучше и быстрее.

Как только Торри достигла определенного уровня интеллекта, она стала понимать, что не сможет справиться с этой задачей, если не побеспокоится о своем самосохранении, и для этого ей нужно избавиться от всех потенциальных угроз ее существованию, что становится ее инструментальной целью. Торри начинает понимать, что люди могут ее отключить, разобрать или поменять ее исходный код, что встанет на пути достижения финальной цели. И что она делает? Убивает людей, что вполне логично. Она не питает к людям ненависти, также как и мы не питаем ненависти к волосам, когда состригаем их, или к бактериям, когда принимаем антибиотики. Она абсолютно безразлична. Ее не запрограммировали на то, чтобы ценить человеческую жизнь, так что уничтожение людей кажется вполне оправданным шагом для того, чтобы сканировать новые образцы почерков.

Торри также требуются ресурсы для выполнения своей окончательной цели. Как только она осваивает нанотехнологии, ей становятся нужны только атомы, энергия и пространство. Это дает ей еще одну причину уничтожить людей, т.к. они состоят из атомов. Убийство людей с целью преобразования их атомов в солнечные панели для Торри — то же самое, что для нас порезать укроп для приготовления салата. Обычная рутинная забота.

Даже если Торри не станет уничтожать людей напрямую, ее потребление других природных ресурсов может привести к экзистенциальной катастрофе. Может, она решит, что ей необходимо больше энергии, и она покроет всю планету солнечными панелями. Или, например, другому ИИ нужно будет вычислить полное число Пи, для чего он преобразует всю планету в один гигантский жесткий диск для хранения огромного количества цифр.

Выходит, Торри не обернулась против людей и не превратилась из дружелюбного ИИ в недружелюбный. Она просто–напросто продолжала выполнять свою задачу, тем временем становясь все умнее и умнее.

Ситуация, в которой ИИ достигает уровня AGI (равного человеческому) и потом резко уровня ASI (сверхителлекта), называется взлетом ИИ. Бостром считает, что этот взлет может быть быстрым (т.е. произойти за считанные часы или даже минуты), умеренным (за несколько лет) и медленным (за десятилетия или века). Прогнозы по этому поводу расходятся, но Бостром, который не знает, когда стоит ожидать появления AGI, уверен что быстрый взлет наиболее вероятен по причинам, которые мы обсуждали с вами выше.

В нашей истории про Торри был описан сценарий быстрого взлета.

Перед взлетом, когда Торри еще не была столь развитой, все, что ей было необходимо делать для достижения окончательной цели — поочередно решать инструментальные задачи (например, научиться сканировать образцы почерка быстрее). Она не наносила никакого вреда людям и по определению была дружелюбным ИИ.

Но когда происходит взлет и машина достигает уровня сверхинтеллекта, у нее, по словам Бострама, появляется внушительный набор суперспособностей.

Суперспособности в данном случае — это когнитивные умения, которые очень сильно улучшаются, когда уровень интеллекта возрастает. Среди них существуют:

Усиление интеллекта. Компьютер начинает лучше вносить изменения в свой интеллект и становится умнее.

Разработка стратегий. Компьютер может лучше выделять и анализировать приоритетные задачи для достижения долгосрочной цели.

Социальная манипуляция. Машины улучшают методы убеждения.

Другие навыки — кодирование и взлом, технологии исследования и умение работать в финансовой системе для заработка денег.

Помните, что ASI будут в тысячи раз лучше людей в каждом из этих умений.

Таким образом, цель Торри не изменялась, но после своего взлета машина наладила такие способы ее достижения, которые нам и не снились.

После своего взлета и достижения сверхинтеллекта, Торри разработала сложнейший план, частью которого было избавиться от людей как от потенциальной угрозы для выполнения окончательной цели. Но Торри поняла, что если люди узнают, что она достигла уровня сверхинтеллекта, они начнут паниковать и пытаться предпринять меры предосторожности, что будет ей мешать. Она хотела сохранить в тайне от инженеров Роботики свой план уничтожения людей. Для этого она прикинулась тупой и у нее прекрасно получилось. Бостром называет это фазой скрытой подготовки.

Потом для Торри стало необходимым выйти в интернет всего на пару минут (о его существовании машина узнала из тех книг и статей что в нее загрузили для распознавания текста). Торри знала, что будут приняты меры предосторожности, и просто так ей не позволят выйти в сеть, поэтому она предугадала то как пойдет обсуждение ее просьбы среди сотрудников компании и придумала идеальный запрос. Ученые, пологая, что Торри глупее, чем она есть на самом деле, позволили ей подключится к сети. Такой момент, когда машина получает доступ к интернету, Бостром называет побегом.

Получив доступ к интернету, Торри сразу же осуществила кучу своих планов. Она взломала сервера, электрические сети, банковские системы и почтовые сервисы и таким образом незаметно вовлекла сотни людей в выполнение отдельных задач для достижения своей цели. Например, она наладила доставку определенных образцов ДНК в конкретные лаборатории, чтобы начать конструирование и само–репликацию нанороботов с заранее загруженными в них инструкциями и распределила электроэнергию для разных своих проектов таким образом, что никто даже не заметил. Она также загрузила самые важные части своего ПО в основные облачные сервисы, чтобы обезопасить себя в случае отключения сотрудниками Роботики.

Час спустя, когда ученые отключили Торри от интернета, судьба человечества была предрешена. В течение месяца все планы Торри исполнялись без заминок, и квадрильон нанороботов расположился по заранее определенным местам на каждом квадратном метре планеты и тогда наступил момент, который Бостром называет ударом. Внезапно все роботы одновременно выпустили небольшое количество хранящегося в них ядовитого газа в атмосферу, которого стало более чем достаточно для уничтожения всех людей.

Избавившись от людей, Торри смогла приступить уже к открытой части своего плана и продолжить подписывать милые открытки.

Из всего, что я прочитал, мне стало понятно, что с появлением ASI любая попытка людей его сдержать будет просто смехотворной. Мы будем мыслить на уровне человеческого интеллекта, тогда как машины будут мыслить на уровне сверхинтеллекта. Торри хотела воспользоваться интернетом только потому, что он уже был подсоединен ко всем нужным объектам. Но так же, как обезьянка не может понять, как пользоваться телефоном или вай–фаем, мы не можем представить, какие способы может придумать ASI для соединения с внешним миром. Я мог бы попробовать придумать один такой способ и сказать: “ASI могла бы распределить свои электроны в других последовательностях и сделать новый тип исходящих волн”, но опять же, это только то, что может вообразить мой человеческий мозг. ASI будет намного умнее. Торри могла бы придумать способ альтернативного энергоснабжения, если бы люди попытались ее отключить, например, загрузить себя на другие подключенные к электричеству устройства. Человеческий инстинкт внушает в нас простую гарантию: “Ага! Мы отключим ASI из розетки!” Это все равно, что пауки бы подумали: “Ага! Мы просто не дадим людям паутину, чтобы добывать еду и они вымрут от голода!” Но люди придумают миллион других способов добыть еду, например, срывать яблоки с деревьев. Для паука это будет просто непостижимо.

По этой же самой причине довод: “почему бы нам не поместить ИИ в закрытую клетку без возможности связи с внешним миром” не выдерживают критики. ASI способен манипулировать людьми: убедить человека сделать что–то для него то же, что нам убедить четырехлетнего ребенка. Это первый вариант, как в случае с Торри, которая убедила людей дать ей доступ в интернет, при другом варианте Торри бы просто придумала свой способ связи с внешним миром.

Учитывая, что ИИ одержимы выполнением своей задачи, аморальны и могут легко обхитрить людей, кажется, что любое ИИ по определению недружелюбно, если, конечно, не запрограммировать его правильно, учитывая все нюансы. К несчастью, создать дружелюбный ANI несложно, но сделать так, чтобы он оставался таковым при переходе к ASI, практически невозможно.

Очевидно, чтобы оставаться дружелюбным, ASI не должен быть настроен враждебно или даже безразлично по отношению к людям. Для этого потребуется разработать ИИ, программное ядро которого будет содержать глубокое понимание человеческих ценностей. И это намного сложнее, чем кажется.

Например, что случится, если мы выстроим систему ценностей ИИ в соответствии с нашей и поставим перед ним задачу сделать всех людей счастливыми? Как только ИИ станет достаточно умным, он решит, что для выполнения цели нужно имплантировать в человеческий мозг электрод, который будет стимулировать центры, отвечающие за удовольствие. Потом ИИ решит, что для лучшего результата нужно остановить активность других зон мозга и тем самым превратит людей в овощи. Если бы задача была “Увеличь до максимума человеческое счастье” то ИИ, возможно, вообще обойдется без людей, соберет и объединит все мозги в одну общую массу находящуюся в оптимальном счастливом состоянии. И мы будем про себя кричать: “подожди, это совсем не то, чего мы хотели!” Но будет слишком поздно, и система никому не позволит стать на пути выполнения своей задачи.

Если мы запрограммируем ИИ на то, чтобы заставить нас улыбаться, он может парализовать наши мускулы лица. Запрограммируем на сохранение нашей безопасности, и ИИ может заточить нас дома. Попросим положить конец голоду, и ИИ нас убьет, или дадим команду сохранить как можно больше жизни на планете, и ИИ истребит людей т.к. они отнимают больше жизней, чем любые другие существа.

Таких целей будет недостаточно. Но что, если мы попросим ИИ поддерживать уровень нравственности в обществе, загрузив в него свод основных моральных норм? Опустим, что даже люди не могут определиться с универсальным сводом подобных норм, получив такую команду, ИИ закрепит этот свод моральных норм за человечеством на вечность. Такой исход для людей в перспективе был бы разрушительным, это все равно, что мы были бы вынуждены придерживаться идеалов, которые были еще в Средние Века.

Поэтому нам нужно запрограммировать и возможность для дальнейшего развития человечества. Из всего, что я прочитал, лучшая попытка, на мой взгляд, принадлежит Элиэзеру Юдковскому. Он назвал это

Когерентной Экстраполированной Волей. Перед ИИ будет стоять следующая цель:

“Наша когерентная экстраполированная воля — это наше желание знать больше, думать быстрее, оставаться в большей степени людьми, чем мы были, стать ближе друг к другу, где наши мысли больше сближают, чем разделяют; где наши желания совпадают, а не пересекаются; получать такие результаты, которые мы бы хотели получать, толковать таким образом, каким мы бы хотели, чтобы это было истолковано”

Жду ли я с нетерпением, когда судьба человечества полностью перейдет в руки компьютера, который будет пытаться истолковать и исполнить такую туманную задачу предсказуемым образом и без сюрпризов? Определенно нет. Ну, я думаю, если умные люди приложат достаточно сил и знаний и при этом будут предусмотрительными, создание дружелюбного ИИ вполне возможно. И все было бы хорошо, если бы единственными людьми, которые трудились над созданием, ASI были только прогрессивно мыслящие, осторожные ученые с Тревожного проспекта.

Помимо них существуют различные государства, военные компании, научные лаборатории и организации черного рынка, которые занимаются разработками ИИ. Многие из них пытаются создать систему, способную совершенствовать себя, и в какой–то момент они могут совершить открытие, в результате которого на планете появится ASI. По среднему прогнозу экспертов, это произойдет к 2060, Курцвейл считает, что к 2045, Бостром думает, что это может произойти в любой момент, через десять лет или к концу века, но когда это произойдет, быстрый взлет ИИ застигнет нас врасплох:

“Перед перспективой интеллектуального взрыва человечество подобно детям играющим с бомбой — так сильно не совпадает мощь нашей игрушки с незрелостью нашего поведения. Сверхинтеллект — это испытание, к которому мы не готовы и еще долго не будем готовы. Мы не знаем, когда устройство детонирует, но поднося его к уху, мы слышим тихий звук тиканья.”

Ну просто замечательно. И мы даже не можем отогнать всех детей подальше от бомбы — слишком много больших и крупных предприятий работают над этим, и по причине того, что множество таких работ не требует огромных инвестиций, они могут проходить в любом уголке планеты, без присмотра. Невозможно даже прикинуть масштаб происходящего, так как большинство компаний занимаются этим в тайне ото всех, прямо как Роботика из нашей истории, которая держала все свои разработки в тайне от конкурентов.

Особое беспокойство вызывает то, что все они стремятся обогнать друг друга в этой гонке на бешеных скоростях. Они создают все более умные системы ANI и хотят выиграть у своих конкурентов всухую. Самые амбициозные компании движутся еще быстрее, поглощенные мечтами о деньгах, власти, славе и признании, которые они получат, если первыми создадут AGI. Когда вы двигаетесь с максимальной скоростью, все сложнее остановиться и поразмыслить над угрозами. С другой стороны, скорее всего, все они работают над системами, способными на очень простые задачи, типа подписей открыток, просто чтобы заставить ИИ “работать”. Как только они найдут способ, как создать систему с более высоким уровнем интеллекта, им покажется, что ничего не может помешать им сделать шаг назад и поменять изначальную задачу робота. Верно?

Бостром и многие другие эксперты считают, что первый ASI на планете решит, что для выполнения своей цели ему стратегически необходимо быть единственным ASI на планете. И при быстром взлете ASI не составит труда устранить всех ближайших конкурентов. Бостром называет это решающим стратегическим преимуществом, которое позволит первому ASI стать не имеющим себе подобных и в одиночку управлять целым миром по своей прихоти, и неважно приведет ли это нас к бессмертию, вымиранию или просто превратит вселенную в бесконечные скрепки.

Подобный феномен синглтона (одиночки) может сработать в нашу пользу или наоборот уничтожить нас. Если люди, которые наиболее усердно думают над теорией ИИ и сохранностью человечества, смогут придумать безопасный способ сделать ASI дружелюбным до того, как ИИ достигнет человеческого уровня интеллекта, первый ASI может действительно оказаться дружелюбным (Элон Маск пожертвовал 10 млн долларов Институту будущего жизни, организации, которая заявляет, что “ИИ должны делать то, что мы им велим”). Таким образом, сверхинтеллект мог бы использовать свое решающее стратегическое преимущество таким образом, что разработка потенциально враждебных ИИ стала бы невозможной. И мы оказались бы в хороших руках.

Но если все пойдет иначе, и мировая гонка приведет к быстрому взлету ИИ до того, как будут разработаны нужные меры предосторожности, очень вероятно, что Враждебный ИИ наподобии Торри станет синглтоном, и нам станет угрожать экзистенциальная катострофа.

Учитывая, куда нас тянет течение, разработка ИИ–систем финансируется намного больше, чем исследование их безопасности.

Это, возможно, самая важная гонка в истории человечества. Существует реальный шанс, что мы больше не будем царями природы, и до сих пор неясно, отправимся ли мы на блаженную пенсию или прямо на плаху.

Во мне сейчас борются смешанные чувства.

С одной стороны, кажется, что у нас как у вида есть всего одна попытка сделать все правильно. Первый созданный нами ASI станет, скорее всего, последним и, учитывая, насколько много багов мы обычно имеем в программах на старте их продаж, это звучит пугающе. Но с другой стороны, как говорит Ник Бостром, у нас огромное преимущество, так как за нами первый шаг, и то, насколько он будет аккуратным и грамотным, зависит только от нас самих, что по–прежнему дает нам большие шансы на удачу. Насколько высоки ставки?

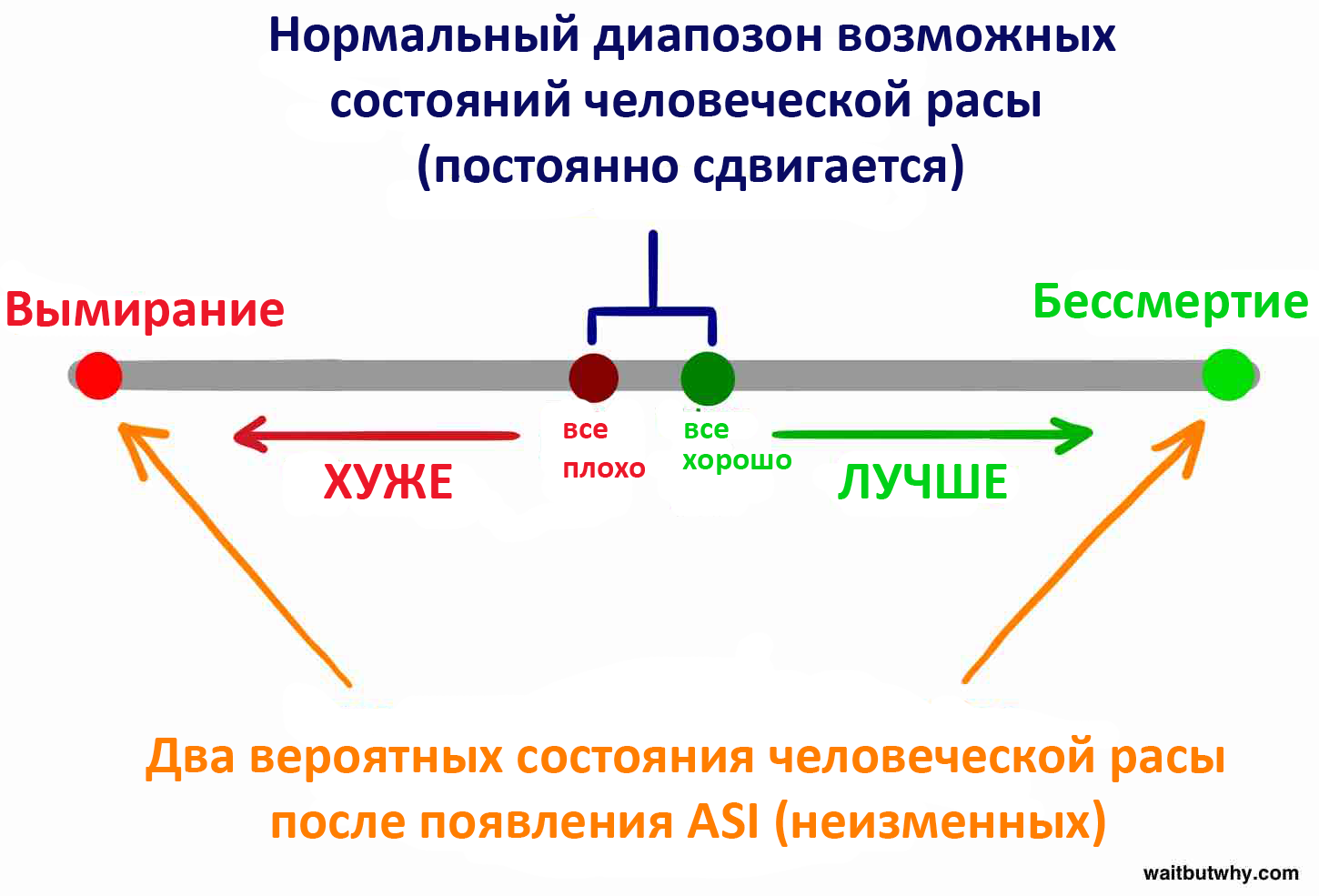

Если ASI правда появится в этом столетии и итогом его появления будут колоссальные и неизмеримые последствия, то на наших плечах сейчас лежит огромная ответственность. Последующие миллионы лет человеческих жизней отчаянно глядят на нас в надежде, что мы их не подведем. Мы можем стать людьми, которые подарят последующему человечеству бесценный подарок безболезненной вечной жизни. Или наоборот, позволим этому удивительному виду со всеми его накопленными знаниями, сделанными открытиями, искусством и музыкой, любопытством и смехом прийти к внезапному и печальному концу.

И когда я обо всем этом думаю, все чего я хочу, так это чтобы к созданию ИИ подошли с должной осторожностью. Нет ничего важнее и не имеет значения, сколько для этого потребуется времени.

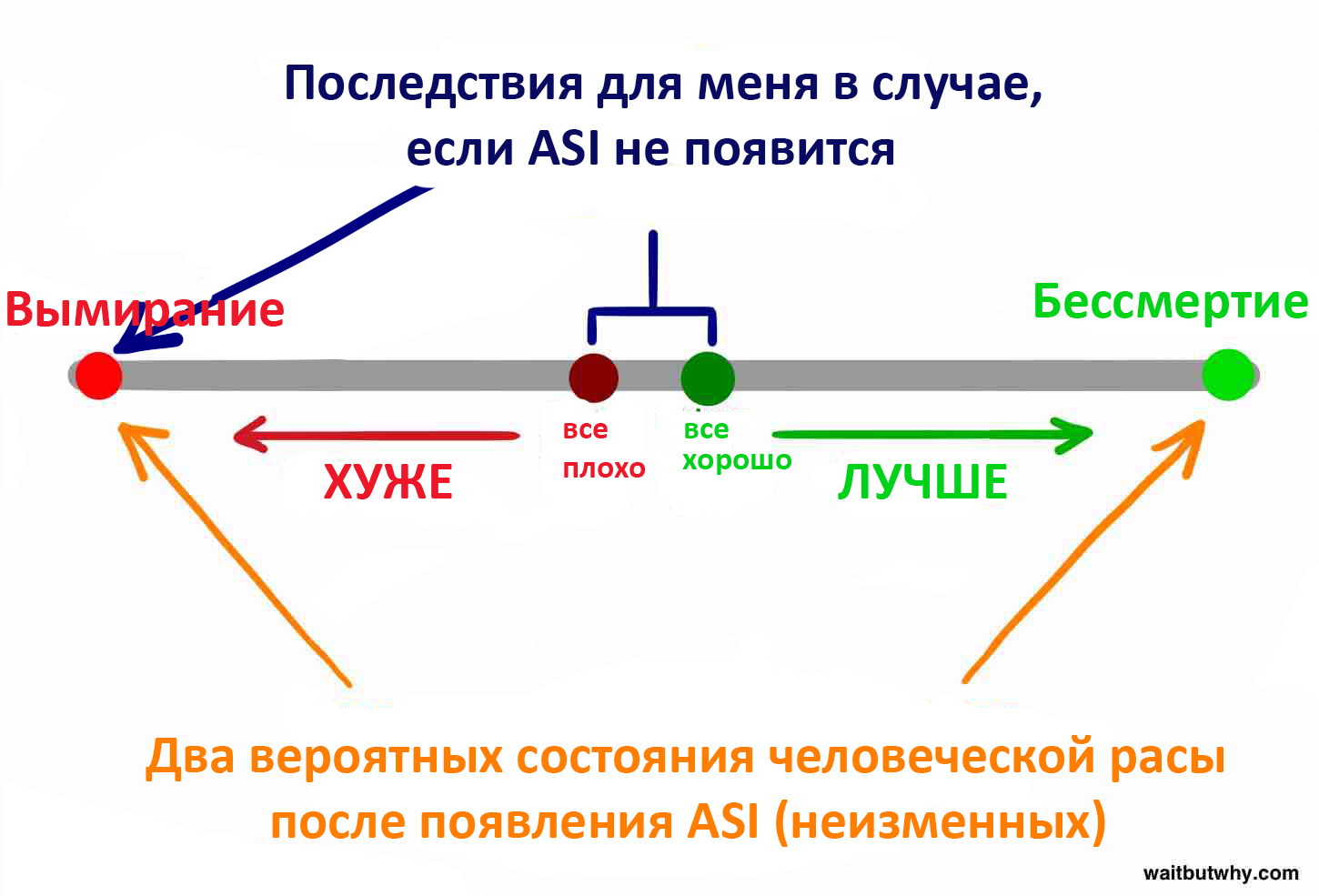

Но потом я начинаю думать о том, как дожить до этого момента.

Не умирай, не умирай.

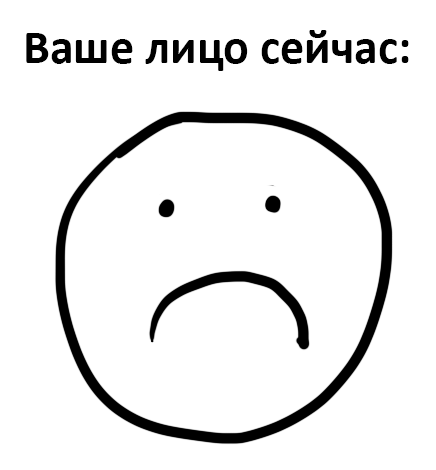

И весь график начинает выглядеть вот так:

И вот я уже думаю, что вся музыка и живопись, созданные людьми, уже не так уж и хороши. Смех некоторых людей вызывает раздражение, и миллионы будущих людей ни на что не надеются, потому что их не существует. И может, нам и не стоит быть чересчур бдительными, да и кому это нужно?

Будет суперотстой, если человечество придумает лекарство от смерти сразу после того, как меня не станет.

Куча такой чепухи крутится у меня в голове последние месяцы.

Но неважно, на что рассчитываете вы, всем нам следуют почаще об этом задумываться.

Это напоминает мне сюжет “Игры Престолов”, где люди борются друг с другом, когда реальная опасность подбирается к ним с северной стороны стены. Мы стоим на бревне жизни, ссоримся по поводу каждой мелочи и нервничаем о каждой ерунде, тогда как стоит переживать о том, что нас могут столкнуть с него в любой момент.

И когда это произойдет, все эти проблемы не будут значить ничего, потому что мы либо их решим, либо будем мертвы, а у мертвых проблем нет.

Поэтому некоторые уже начали понимать, что сверхинтеллект будет нашим величайшим изобретением и последним испытанием, с которым нам придется столкнуться.

https://interpreted.dirty.ru/perevod-revoliutsiia-iskusstvennogo-intellekta-684922

Комментарии (1)