Проблема контроля и активный поиск внеземного интеллекта

Мы уже писали о том, что, как считают трансгуманисты и сторонники постбиологического подхода к исследованию космоса в астробиологии, следующим этапом интеллектуальной эволюции на Земле будет развитие машинного интеллекта. Мы все живём на промежуточной ступени эволюционной лестницы, в переходный период. Некоторые — такие, например, как РэйКурцвейл — утверждают, что человечество сольётся с машинами и достигнет таким образом биологического бессмертия. Но другие смотрят на будущее намного более мрачно. К примеру, Ник Бостром, Стивен Хокинг, Билл Гейтс и Илон Маск были обеспокоены тем, что, разрабатывая формы искусственного интеллекта, люди могут над ним потерять контроль, так как суперинтеллект может переписать свои программы и обойти любые меры контроля, предусмотренные нами. Так появилась «проблема контроля», суть которой сводится к вопросу о том, как контролировать искусственный интеллект, который оказался выше интеллекта человека.

Мы уже писали о том, что, как считают трансгуманисты и сторонники постбиологического подхода к исследованию космоса в астробиологии, следующим этапом интеллектуальной эволюции на Земле будет развитие машинного интеллекта. Мы все живём на промежуточной ступени эволюционной лестницы, в переходный период. Некоторые — такие, например, как РэйКурцвейл — утверждают, что человечество сольётся с машинами и достигнет таким образом биологического бессмертия. Но другие смотрят на будущее намного более мрачно. К примеру, Ник Бостром, Стивен Хокинг, Билл Гейтс и Илон Маск были обеспокоены тем, что, разрабатывая формы искусственного интеллекта, люди могут над ним потерять контроль, так как суперинтеллект может переписать свои программы и обойти любые меры контроля, предусмотренные нами. Так появилась «проблема контроля», суть которой сводится к вопросу о том, как контролировать искусственный интеллект, который оказался выше интеллекта человека.

Как замечает Бостром, сверхразумный искусственный интеллект способен возникнуть в момент технологической сингулярности, когда ускоренное технологическое развитие, и, в первую очередь, интеллектуальный взрыв, достигнет точки, в которой люди без искусственно усиленного интеллекта уже не сумеют делать прогнозы или даже понимать происходящие изменения. Произойди интеллектуальный взрыв — и люди потеряют возможность контролировать или предсказывать основные цели сверхразумного искусственного интеллекта. Моральные принципы сложно загрузить в машину на манер защиты от дураков, и суперинтеллект может всегда эти принципы переписать. До настоящего времени продолжаются споры о том, какие именно нормы морали стоит прописать искусственному интеллекту. Более того, умная машина может обходить подобные меры безопасности, как попытки изоляции и выключатели убийства, и потенциально представляет для человечества экзистенциальную угрозу. А чему здесб удивляться, если, как гласит определение, суперинтеллект умнее человека в каждой сфере деятельности.

Проблема контроля — серьёзная, даже, вероятно, непреодолимая проблема. Не случайно, прочитав книгу Бострома, бизнес-лидеры и учёные — такие как Билл Гейтс, Стивен Хокинг, Макс Тегмарк и другие — высказались в том духе, что суперинтеллект способен угрожать человечеству, так как цели сверхразумного искусственного интеллекта нельзя будет ни предвидеть, ни контролировать. В настоящее время большинство работ по проблеме контроля написано учёными-компьютерщиками. К ним могут присоединиться философы, изучающие ум и мораль, чтобы внести свой вклад в работу над созданием дружественного искусственного интеллекта(если нужен превосходный обзор работ на данную тему.

А что предлагаю я? На мой взгляд, создавая систему контроля, включающую этическое программирование, важно также, по возможности, разработать, хотя бы в общих чертах, средства оперативного осмысления вычислений сверхразумного искусственного интеллекта. Будет короткий интервал времени между разработкой передовых форм ИОИ, то есть сильного (универсального) искусственного общего интеллекта (artificialgeneralintelligence, AGI), и суперинтеллекта, и, когда наступит это время, любая нынешняя работа, посвящённая природе суперинтеллектуальных вычислений, может оказаться весьма полезной для осуществления контроля над сверхразумным искусственным интеллектом. Добавлю, что человеческое понимание сверхразумного искусственного интеллекта, по-видимому, будет усилено синтетическими средствами повышения интеллекта, и интеллектуально модернизированному человеку будет легче интерпретировать поведение и когнитивную обработку информации сверхразумного искусственного интеллекта. Данная статья может стать отправной точкой для дальнейшей, более тщательной проработки затронутых мной вопросов.

В настоящее время не имеется понимания того, что продвинутый ИОИ, который технически не является суперинтеллектом, может быть опаснее сверхразумного искусственного интеллекта. ИОИ, даже уступая нашему разуму в каких-то сферах деятельности, может превзойти его в других сферах, получить доступ к интернету, попасть в руки преступных организаций. Недостаточная сообразительность в одной или нескольких областях в сочетании с изощрённой сообразительностью в других может представлять особую опасность. ИОИ может на нет свести все попытки изолировать его или ещё каким-либо способом контролировать его действия, может интегрировать разные типы входов, то есть создать грубый аналог ассоциативных зон головного мозга, и всё же оставаться очень недоразвитым в некоторых областях, создавая для человечества серьёзную угрозу. При этом структура ИОИ может быть весьма сложной, особенно в тех областях, где он превосходит людей. Разработка путей понимания такого рода систем, по-видимому, весьма полезна.

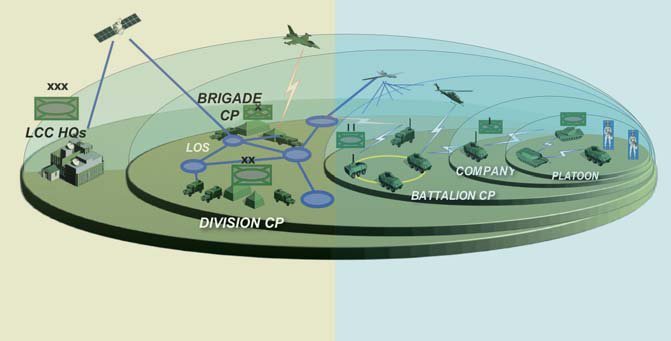

Оставив в стороне сугубо земные дела, давайте рассмотрим в контексте вопросов, которые связаны с проблемой контроля, возможные последствия обнаружения где-то во Вселенной суперинтеллектуального искусственного интеллекта. При серьёзном отношении к контролю было бы недальновидно игнорировать потенциальную опасность такого открытия. Цели иноземных форм сверхразумного искусственного интеллекта установить трудно, и, хотя мы можем утверждать, что часть из них — биологически инспирированные суперинтеллектуальные инопланетяне(БИСИ), остальные ими не являются. И даже биологически инспирированные суперинтеллектуальные инопланетяне могут эволюционировать непредсказуемым образом. Сторонники активного поиска внеземного интеллекта настаивают на том, что кроме прослушивания космоса в надежде поймать сигналы внеземного интеллекта необходимо, используя наши самые мощные радиопередатчики, такие как гигантский радиотелескоп в Аресибо, Пуэрто-Рико, отправлять сообщения в направлении ближайших к Земле звёзд. Однако в свете проблемы контроля программа активного поиска внеземного интеллекта выглядит недальновидной. Хотя для действительно развитой цивилизации человечество, вероятно, не представляет никакого интереса, нам следует воздерживаться от активного поиска внеземного интеллекта, пока мы не достигли уровня развития, позволяющего не опасаться сверхразумного искусственного интеллекта.

Сторонники активного поиска внеземного интеллекта могут отреагировать на данную рекомендацию так: наши радиолокационные и радиосигналы уже доступны для перехвата извне. Однако это обстоятельство никоим образом не вынуждает нас посылать в космос гораздо более мощные сигналы (да ещё и транслировать, как кое-кто настаивает, содержание интернета), усиленно осуществляя активный поиска внеземного интеллекта. Не стоит предполагать, что сверхразумный искусственный интеллектне сделают нам ничего плохого, если мы инициировали контакт. Это антропоцентрическая позиция. Дальнейшие усилия, направленные на то, чтобы нас заметили, могут оказаться критичными. На мой взгляд, разумнее придерживаться стратегии пассивного прослушивания и даже стараться маскировать наши исследующие космос устройства, ибо столкновение с деструктивным сверхразумным искусственным интеллектом, даже если оно маловероятно, это — серьёзный экзистенциальный риск.

Теперь перейдём к рассмотрению возможных социальных и философских последствий.

Комментарии (0)